Manche Marktteilnehmer sehen bereits die unternehmerische Entscheidungsfreiheit und sogar nationale Handlungsspielräume eingeschränkt und fordern Gegenmaßnahmen: Die „digitale Souveränität“ der Bundesrepublik Deutschland sei gefährdet.

Dieser Begriff, der gerade auf diversen Publikationen und Medien gehypt wird, suggeriert bewusst, die Souveränität unseres Staates (oder zumindest der digitale Teil davon – was das auch immer sein soll) sei wahlweise von Amerika oder wenigstens von Microsoft ernsthaft bedroht.

Huch, in welche Diskussion sind wir hier denn geraten?

Sicher, man hat sich in den letzten Jahren daran gewöhnt, dass gerade politische Diskussionen gerne mit Halbwahrheiten und persönlichen Ansichten emotional aufgeheizt werden. Und an Microsoft reiben sich traditionell gerne ganze Bevölkerungsschichten. Hilfreich ist das nie.

Lassen Sie uns die Situation daher etwas nüchterner betrachten.

Wirtschaftliche Interessen dominieren sicherheitspolitische

Zunächst einmal geht es in aller Regel vorrangig um wirtschaftliche Interessen und erst in zweiter Linie um nationale: Die Hersteller möchten ihre Produkte und Leistungen verkaufen und die Kunden für ihren Zweck optimal geeignete Software einsetzen. Optimal bedeutet hierbei:

- Die gewünschte Funktionalität wird erreicht.

- Sicherheitsvorgaben, rechtliche Vorschriften und Compliance-Regeln können eingehalten werden.

- Die Anschaffungs- und Betriebskosten bleiben in dem Rahmen, den das angestrebte Geschäftsziel vorgibt.

Dies gilt für private Unternehmen sowieso, aber auch öffentliche Unternehmen und Behörden müssen Budgetvorgaben einhalten und sind an optimierten Betriebsabläufen interessiert (zumindest wünscht sich dies der geplagte Steuerzahler).

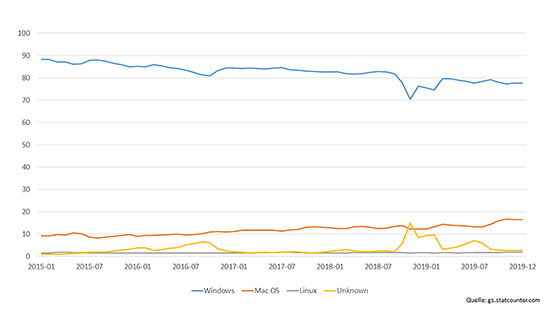

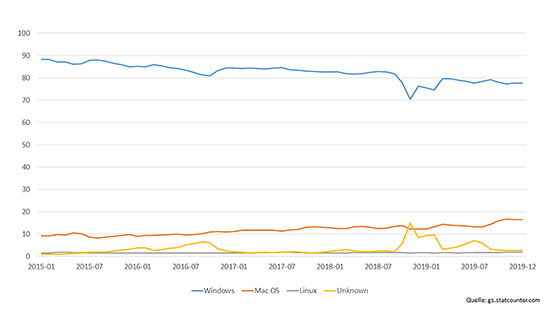

Abbildung 1: Marktanteile Desktop-Betriebssysteme

In letzter Konsequenz heißt das, dass selbst der gerne als Killerargument vorgebrachte Datenschutz sich diesen Vorgaben unterordnen muss. Sicherheit ganz allgemein läuft fast immer Betriebsvereinfachungen zuwider, und IT (früher nannte man das EDV – elektronische Datenverarbeitung!) bedeutet immer, kalkulierte Risiken auch und gerade beim Datenschutz zugunsten von Geschäftsprozessen und Unternehmenszielen in Kauf zu nehmen. Vollständigen Schutz aller Daten gibt es eben genauso wenig wie die vielzitierte hundertprozentige Sicherheit – und ist im Grunde auch unnötig. In jedem Bereich gibt es sensible und weniger sensible Daten. Nicht jeder kompromittierte Kantinenplan gefährdet die nationale Sicherheit. In der Regel sind Dokumente und Informationen, die als streng geheim behandelt werden müssen, deutlich in der Minderheit.

Wo liegen also ernsthafterweise die Probleme? Folgende drei Punkte werden regelmäßig diskutiert:

- Es bilden sich in immer mehr Teilmärkten monopol- oder oligopolartige Strukturen.

- Die Marktführer sind in außereuropäischen Ländern, der Großteil in den USA beheimatet, und es ist damit unklar, inwieweit deutsche und europäische Gesetze eingehalten werden oder durchgesetzt werden können.

- In einigen Staaten, vermehrt auch in den USA, nehmen staatliche Stellen unverhohlen Einfluss auf die dort ansässigen Unternehmen.

Auf keinen der drei Punkte hat ein einzelnes Unternehmen ernsthaft Einfluss!

Marktführer, aber keine Monopole

Nun, glücklicherweise gibt es im Softwaremarkt keine echten Monopole, so dass aus marktpolitischer Sicht die Situation gar nicht so dramatisch ist, wie sie oft dargestellt wird. Wir haben im Folgenden vier wichtige Segmente mit klaren Marktführern und zum Teil sehr wenigen alternativen Anbietern herausgepickt und zeigen die aktuelle Lage:

- Bei den Desktop-Betriebssystemen dominiert zweifellos Microsoft mit Windows den Markt. MacOS ist in einigen Sparten zwar eine gängige Alternative, gewinnt aber kaum Marktanteile (siehe Abbildung 1). Durch die Fixierung auf Hardware von Apple ist das Betriebssystem eben recht unflexibel und aufgrund der Anschaffungskosten dieser Hardware auch ziemlich teuer.

Darüber hinaus wird Linux immer wieder als Alternative ins Spiel gebracht, aber auch gegen Linux sprechen die eingeschränkte Unterstützung von Peripheriegeräten und vor allem Tausende von Softwareprodukten, die eben meist dediziert für Windows entwickelt wurden und nur in einer Windows-Umgebung laufen. Schon allein die vielen Eigenentwicklungen auf Linux umzustellen, ist in vielen Umgebungen schlicht unmöglich. Das Linux-Abenteuer der Stadt München ist daran gescheitert und wird sicherlich nicht so schnell Nachahmer finden. Die Marktanteile von Linux im Desktop-Markt stagnierten daher auch 2019 deutlich unterhalb der Zwei-Prozent-Marke.

- Noch enger ist die Situation bei Bürosoftware. Microsoft Office ist nach wie vor unangefochtener Spitzenreiter, sowohl in Deutschland als auch weltweit, auch wenn Googles G-Suite im direkten Vergleich der Cloud-Angebote mit Office 365 deutlich aufgeholt, im weltweiten Vergleich sogar gleichgezogen hat.

Die einzigen zwar unbeliebten, aber zur Not gangbaren Alternativen hierzu sind OpenOffice und LibreOffice, deren Marktanteile aber kaum der Rede wert sind. Weitere Office-Suites stehen zwar hauptsächlich für Linux zur Verfügung und leiden in der Regel jedoch unter der Einschränkung, dass sie nicht mit den Dokumentenformaten von Microsoft Office kompatibel sind.

- Bei den Server-Betriebssystemen hat Microsoft die Marktführerschaft mittlerweile verloren. Gerade Webprojekte werden in ihrer großen Mehrheit mit Linux-Servern betrieben. In Unternehmensnetzen werden neben den frei verfügbaren Distributionen wie Debian, Ubuntu, Fedora, CentOS und anderen hauptsächlich die beiden kommerziellen Produkte Red Hat Enterprise Linux (RHEL) und SUSE Linux Enterprise Server (SLES) genutzt, für die es auf Unternehmenskunden ausgelegte Supportangebote gibt.

Windows Server dürfte aber nach wie vor einen Marktanteil von 30 bis 50 % haben. Vor allem für die weitverbreiteten Infrastruktur- und Plattformprodukte von Microsoft wie Active Directory, Exchange, SharePoint und andere wird Windows Server (noch) zwingend vorausgesetzt. Darüber hinaus setzen gerade kleine mittelständische Firmen und Niederlassungen auf Windows Server, wenn dort kein eigenes Linux-Know-how vorhanden ist.

Interessanterweise lockert Microsoft selbst die Vorgaben zum Betrieb der eigenen Serveranwendungen. So kann zum Beispiel der SQL-Server 2019 außer auf Windows Server auch unter Linux und als Docker-Container installiert werden. Die Gründe hierfür dürften in dem rasant wachsenden Bedarf an auf Microservices basierenden Containerlösungen für Web-, IoT- und Big-Data-Lösungen liegen.

- Im Hypervisor-Markt ist trotz eines interessanten Aufholspurts von Microsofts Hyper-V in den vergangenen Jahren VMware vSphere weiterhin unangefochten Marktführer mit einem Marktanteil von ca. 80 %. VMware hat verlorene Marktanteile in den letzten Jahren in erster Linie durch das Konzept Software-defined Datacenter (SDDC) zurückgeholt, womit im Rechenzentrum eine durchgehende Virtualisierungsebene nicht nur für Compute-Ressourcen, sondern auch für Speicher und insbesondere für Netzwerkdienste umgesetzt werden kann.

Microsoft Hyper-V realisiert zwar ähnliche Ideen, setzt aber deutlich stärker auf eine transparente Integration mit der Azure-Cloud und konnte damit bislang im Enterprise-Umfeld nicht richtig punkten (siehe auch „Distributed Cloud: Erobern Hyperscaler unsere RZs?“ [1]).

Die anderen Mitspieler wie KVM oder Red Hat Virtualization sind dagegen technologisch abgeschlagen, haben aber natürlich trotzdem aufgrund geringster Anschaffungskosten und der einfachen Integration in Linux- und containerbasierende Umgebungen einige Verbreitung.

Rein marktpolitisch gibt es also kaum Anlass, nach regulatorischen Maßnahmen zu rufen. In allen betrachteten Segmenten gibt es starke Alternativen, und man sollte nicht unterschätzen, wie schnelllebig Softwaremärkte sind. Unvergessen sind beispielsweise die sogenannten Browserkriege: Im Jahr 2002 lag der Marktanteil von Microsoft Internet Explorer bei rund 90 %, dann wuchs der Anteil von Firefox bis 2009 zwischenzeitlich auf fast 25 %. Mittlerweile (2019) werden für Google Chrome Anteile von über 65% angegeben, während beide Microsoft-Browser zusammen nur knapp über 10 % liegen.

Die obige Liste ließe sich noch um viele weitere Beispiele verlängern. Nicht nur bei Softwareprodukten gibt es das Problem, dass ein oder zwei dominierende Hersteller die Märkte bestimmen. Auch Hardware- und hardwarelastige Marktsegmente sind hiervon betroffen:

- Apple ist praktisch alleiniger Anbieter von Betriebssystemen und Software für Apple-Produkte.

- Google bestimmt wesentlich die Entwicklung von Android und kontrolliert damit mit Apple zusammen weit über 90 % aller Smartphones und Tablets.

- Ähnlich hohe Marktanteile hat Google bei vielen Webtechnologien wie zum Beispiel mit ihrer Suchmaschine, mit Google Analytics, mit Chrome u. a. m.

- Cisco ist seit Jahren der führende Lieferant für aktive Netzwerkkomponenten in Unternehmensnetzen.

Das Problem heißt Herstellerabhängigkeit

Für das einzelne Unternehmen spielen Betrachtungen zu Marktanteilen aber meist eine eher untergeordnete Rolle. Das eigentliche Problem besteht darin, dass sich das Unternehmen mit der Auswahl eines bestimmten Produktes oder einer Architekturentscheidung meist für Jahre oder gar Jahrzehnte in die Abhängigkeit des jeweiligen Herstellers begibt. Ein Wechsel ist meist schwer, schwerer und aufwändiger als ein Release-Wechsel beim selben Hersteller. Dabei spielt es keine Rolle, ob die Bezugsquelle der Marktführer, ein Herausforderer oder die Open-Source-Community ist.

Marktanteile spiegeln lediglich wider, wie viele Unternehmen sich für dieses oder jenes Produkt entscheiden, aber nicht deren Gründe. Wer aber die Marktmacht gerade amerikanischer Hersteller kritisiert und nach Alternativen sucht, muss die Beweggründe verstehen, warum sich Menschen so oft und vor allem so beständig für die Produkte von Marktführern entscheiden.

Im Consumer-Bereich scheinen die Motive einfach zu sein: Die großen Treiber sind Kommunikation, Social Networking und die Unterhaltungsbranche. Alles drei funktioniert am besten, wenn alle dasselbe Tool nutzen – und wenn die Schwarmintelligenz das Tool wechselt, folgen alle andern nach. Sonstige Kriterien spielen eine eher untergeordnete Rolle: Wo es das Ziel ist, möglichst jede Emotion und Tätigkeit mit der ganzen Welt zu teilen, hat der Schutz der Privatsphäre naturgemäß keine große Bedeutung. Und wenn dann noch dazu kommt, dass die Nutzung von Anwendungen mit den eigenen Daten ohne finanzielles Engagement „bezahlt“ werden kann, sind die meisten Anwender rundum zufrieden. Der Erfolg von Facebook, WhatsApp und Instagram ist tatsächlich leicht zu erklären.

Ganz so schmalspurig sind Entscheidungsprozesse im Unternehmensumfeld nicht. Hier spielen dann doch eher Themen wie Produktivität, Gesamtbetriebskosten und Datensicherheit eine Rolle. Kriterien für die Einführung von Software sind in der Regel:

- Die erwartete Funktionalität wird erreicht.

- Der Support und die Dokumentation entsprechen den Erwartungen und dem Nutzungsumfang. Selbst in mittleren Unternehmen wird heute oft eine 24×7-Erreichbarkeit des Produktsupports gefordert.

- Es ist eine breite Interoperabilität mit Peripheriegeräten jeglicher Art gewährleistet. Dies gilt natürlich in erster Linie für Betriebssysteme.

- Es existieren Öko-/Partnersysteme, über die fehlende Funktionen im Basisprodukt ergänzt werden können.

- Es existieren Management- und Orchestrierungsprodukte, in die das Produkt eingebunden und zentral administriert werden kann, um Betriebsaufwände zu minimieren und die Nutzung zu überwachen.

In vielen dieser Punkte haben große, kommerzielle Anbieter meist klare Vorteile. Was nutzt mir eine perfekt auf mein Unternehmen zugeschnittene Anwendung, wenn der Support nur durch eine oder zwei Personen geleistet werden kann, wenn ich jeden neuen Mitarbeiter aufwändig schulen muss, wenn neue Technologien oder Bedienkonzepte nicht integriert werden können?

Apropos Mitarbeiter: auch die Benutzerakzeptanz ist bei bekannten Softwareprodukten meist deutlich höher. Das bedeutet nämlich, Sie finden einfacher Mitarbeiter und Administratoren, wenn die das Produkt bereits kennen, und Sie können Schulungsmaßnahmen minimieren.

Warum ist Herstellerabhängigkeit kritisch zu bewerten?

In der Regel werden bezüglich Abhängigkeit von Herstellern drei Aspekte diskutiert:

- Nicht kalkulierbare Kosten: Der Hersteller kann die Lizenzkosten und Nutzungsbedingungen nach Belieben durchsetzen.

- Proprietäre Leistungsmerkmale und Datenformate: Der Hersteller kann über proprietäre Dateiformate, proprietäre Integrationsschnittstellen und die Zusammenarbeit mit Partnern (Stichwort Ökosystem) seine bestimmende Position weiter ausbauen und den Wechsel zu einem Mitbewerber erschweren.

- Mangelnde Transparenz: Der Hersteller konzentriert sich auf Leistungsmerkmale, die seine eigene Marktposition stärken, und ignoriert den Bedarf und die Interessen seiner Kunden. Insbesondere die Punkte Stabilität der Software und Sicherheit von Daten werden hierbei oft bemängelt.

Ist Open Source das Allheilmittel?

Gerade bei der Auseinandersetzung mit einem der großen Softwarehersteller wie beispielsweise Microsoft wird gerne auf Open-Source-Software (OSS) als Königsweg aus allen Problemen verwiesen. Ich weiß, dass gerade unter IT-affinen Menschen viele einen geradezu verklärten Blick auf Open Source haben, aber ein Allheilmittel ist leider auch Open-Source-Software nicht.

Schauen wir uns zunächst das Kostenargument an. Zwei Aspekte werden hier gerne übersehen:

- Erstens bedeutet Open Source nicht automatisch „kostenfreie Lizenz“ oder „kostenfrei im Unternehmensumfeld nutzbar“, und

- zweitens muss man – und hier unterscheiden sich Unternehmen eben von Verbrauchern – die Gesamtkosten sehen und nicht allein die Anschaffungs- oder Lizenzkosten.

Unumstrittene Marktführer wie Microsoft im Büroumfeld oder VMware im Virtualisierungsbereich sind ja nicht Marktführer, weil sie ihre Kunden mit völlig überhöhten Lizenzgebühren quälen, sondern vielmehr trotz dieser zum Teil tatsächlich hohen Kosten! Man muss in dieser Diskussion ganz nüchtern feststellen, dass diese Produkte den meisten Unternehmen und eben auch Behörden diese Kosten wert sind. Die Gründe entsprechen weitgehend der obigen Liste: leichte Integration, technologische Führerschaft, zentrale Administrierbarkeit, wenig Schulungsbedarf für Mitarbeiter und Administratoren, geringe Betriebskosten.

Auch beim Punkt „proprietäre Leistungsmerkmale und Datenformate“ kommt OSS nicht wesentlich besser weg, wie es die Befürworter glauben machen wollen.

So existiert im Bereich Bürosoftware beispielsweise mit OpenDocument zwar ein von der ISO/IEC international standardisiertes Dateiformat, aber auch Microsoft hat „seine“ Office-Open-XML-Formate (OOXML) zur kostenfreien Nutzung offengelegt und bietet darüber hinaus die Option an, OpenDocument als Standard für neue Dokumente zu verwenden. Die aktuelle Situation ist die, dass alle wesentlichen Office-Suiten von Microsoft Office über OpenOffice/LibreOffice bis Google Docs sowohl OpenDocument als auch OOXML lesen und schreiben können. Lediglich Google hat seine intern verwendeten Formate nicht offengelegt. Das heißt, Bürodokumente können recht problemlos von einem Format ins andere konvertiert werden. Das ist nicht schön, aber auch nicht dramatisch, einen Hinderungsgrund, auf ein anderes Softwareprodukt zu wechseln, stellt das Dokumentenformat jedenfalls nicht dar.

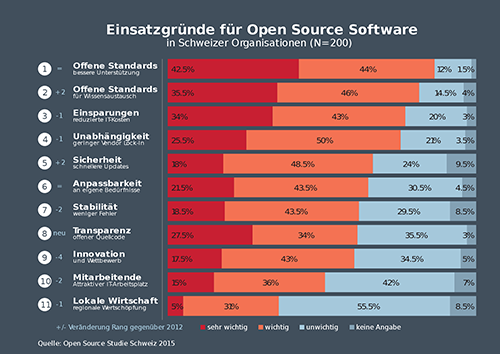

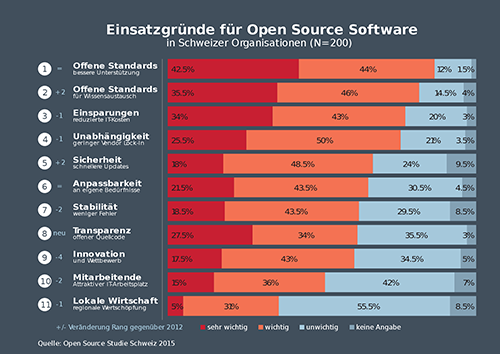

Abbildung 2: Einsatzgründe für Open-Source-Software

Hinderlicher sind in diesem Zusammenhang eher sogenannte Makros, die sich in vielen Unternehmen und öffentlichen Verwaltungen großer Beliebtheit erfreuen. Makros sind und waren schon immer der größte Hemmschuh selbst bei Versionsupdates desselben Produktes. Aber auch hier unterscheiden sich Microsoft Office und LibreOffice zumindest konzeptionell nicht. Vielleicht löst sich dieses Grundübel in Zukunft auch in Luft auf. Bislang werden jedenfalls Makros bei einer Dokumentenbearbeitung in der Cloud nicht unterstützt.

Beim Blick auf „Leistungsmerkmale“ muss man feststellen, dass kommerzielle Produkte oft besser und schneller auf Kundenbedürfnisse reagieren als viele Open-Source-Projekte. Typisches Beispiel ist VMware, deren Portfolio klar und deutlich auf Unternehmenskunden zugeschnitten ist – anders als Open-Source-Lösungen, für die nach wie vor viel Linux-Know-how und CommandLine-Affinität notwendig sind.

Spannend ist auch die Gründung der Open- Data- Initiative, deren Ziel es ist, ein einheitliches Datenschema für Unternehmensdaten zu entwickeln, um so einfacher von der Anwendung des einen Herstellers auf die Daten in der Anwendung eines anderen Herstellers zugreifen zu können – beispielsweise zur Analyse oder auch um die Daten zu übertragen. Ins Leben gerufen wurde diese Initiative von Adobe, Microsoft und SAP, also von den großen kommerziellen Herstellern mit hohen Marktanteilen. Erst ein Jahr später reagierte die Linux Foundation und legte zusammen mit AWS, Salesforce und Genesys mit dem „Cloud Information Model“ einen Gegenentwurf vor. Die Frage, ob hier ein zweites Modell sinnvoll und zielführend ist, werden wir beobachten und an anderer Stelle diskutieren. Ärgerlich ist es für die Kunden und den Markt allemal.

Ein weiterer Knackpunkt bei OSS ist, dass aufgrund der internen Struktur vieler Projekte deren Kontinuität und Fortbestehen nur durch freiwillige Zahlungsgeber gesichert werden können. Die Projekte geraten damit leicht unter fremden Einfluss. Das Ergebnis ist oft genug das Ende des Projekts oder ein sogenannter Fork, das Aufsplitten in zwei unabhängige Produkte.

Ist Closed Source unsicherer als Open Source?

Kommen wir zum dritten Komplex „Datenschutz und Transparenz“. Naturgemäß ist Transparenz die grundlegende Eigenschaft, die OSS von Closed-Source-Software unterscheidet: Jeder kann den Quellcode einsehen und jeder kann auf der Basis des verfügbaren Quellcodes „seine“ Anwendung kompilieren. Naja, theoretisch wenigstens, in der Realität wird das kaum jemand machen.

Dieses Grundprinzip der offengelegten Codebasis verleitet vielfach zu der Meinung, OSS sei per se sicherer und habe weniger Sicherheitslücken als Closed Source. Dafür gibt es keinerlei Nachweise.

Spannender ist aber allemal die Frage nach versteckten Codeteilen zum Nachteil des Kunden. Diskutiert werden meist zwei Szenarien: das Ausspionieren des Nutzerverhaltens und der Einbau sogenannter Hintertüren (Backdoors), um die Software von außen steuern zu können. Beides passiert zweifelsohne, beides ist aber keineswegs auf Closed-Source-Software beschränkt (bei OSS kann man es aber nachweisen).

Gerade die Übermittlung von Nutzer- und Nutzungsdaten, sogenannter Telemetriedaten, ist heutzutage weit verbreitet und wird meist ganz offen betrieben – DSGVO hin oder her. Auch Microsoft übermittelt bei Windows 10 umfangreiche Telemetriedaten, nach Aussagen des Herstellers, um die Qualität und die Sicherheit des Betriebssystems kontinuierlich zu verbessern. Außerdem werden diese Daten dazu genutzt zu entscheiden, wer zu welchem Zeitpunkt die regelmäßig erscheinenden Updates von Windows 10 erhält. Beides ist sinnvoll und dürfte von der Mehrheit der Benutzer so akzeptiert werden. Das Problem liegt vielmehr darin, dass

- diese Aussagen praktisch nicht überprüfbar sind,

- Microsoft ähnlich wie Google und andere die gesammelten Daten nur sehr widerstrebend offenlegt,

- es kein einfach zu bedienendes Konfigurationsmenü gibt, um die Sammelwut des Herstellers einzudämmen und

- nicht einzusehen ist, warum der Hersteller so viele Daten braucht (wie beispielsweise jede halbe Stunde ein „HeartBeat“).

Das BSI (Bundesamt für die Sicherheit in der Informationstechnik) hatte 2018 die Telemetriekomponente in Windows 10 analysiert und Empfehlungen veröffentlicht . Leider ist das Dokument nicht mehr ganz aktuell. Immerhin hat der öffentliche Druck dazu geführt, dass Microsoft mittlerweile das Tool „Diagnosedatenanzeige“ zur Verfügung stellt, mit dessen Hilfe die übermittelten Telemetriedaten eingesehen werden können.

Die Nichtüberprüfbarkeit von Aussagen der Hersteller ist die große Schwäche von Closed Source. Man kann glauben, was der Hersteller sagt oder nicht. Damit sind Verschwörungstheorien Tür und Tor geöffnet. Bei OSS kann man nachschauen.

Das gilt auch für tatsächliche oder vermeintliche Backdoors. Jenseits von mehr oder weniger offensichtlichen und offengelegten Geschäftsinteressen wie den eben diskutierten Telemetriedaten ist es unsinnig, Herstellern zu unterstellen, sie würden ihre Produkte dahingehend verändern, dass sie auf Kundendaten zugreifen können. Was hätten sie davon? Der Imageschaden, wenn so etwas herauskommt, dürfte in jedem Fall immens, gegebenenfalls existenzgefährdend sein.

Die Diskussion um die Beteiligung des chinesischen Herstellers Huawei beim Aufbau unserer 5G-Infrastruktur dürfte hinlänglich bekannt sein und bewegt sich in genau diesem Bereich. Es mischen sich technisches Unverständnis und tiefes Misstrauen gegen ausländische Hersteller mit politischem Kalkül. Die diskutierten Fragen sind:

- Sind Infrastrukturkomponenten wie die diskutierten nur für den Transport von Daten zuständig oder haben sie auch Einfluss auf den Schutz der transportierten Daten?

- Hat die chinesische Regierung so großen Einfluss auf Huawei, dass der Hersteller Backdoors in die Software einbauen würde?

- Haben die Chinesen einen Vorteil, wenn, sagen wir mal, die Infrastruktur für autonome Fahrzeuge in Deutschland nicht mehr vollständig funktionierte?

- Stehen bei den USA, die diese Diskussion hauptsächlich treiben, nicht vornehmlich wirtschaftliche Interessen im Vordergrund?

Der Kernpunkt dieser Diskussionen ist doch, dass meist nicht dem Unternehmen Huawei eine böse Absicht unterstellt wird, sondern staatlichen Organen von China – da wird es politisch. Im Kern ist das die gleiche Diskussion, wie sie über Microsoft, Google, Apple und andere geführt wird: Welchen Einfluss haben staatliche Stellen auf die Ausgestaltung und den Funktionsumfang von Software?

Und hier spielen keineswegs nur chinesische oder amerikanische Regierungen eine fragwürdige Rolle, auch die EU und die deutsche Bundesregierung drängen vermehrt darauf, Einblick in Kommunikationsbeziehungen zu bekommen!

Wo steht die Bundesregierung?

Der Bundesregierung scheint aufgefallen zu sein, dass deutsche und europäische Unternehmen ihre IT-Produkte und IT-Leistungen hauptsächlich von US-amerikanischen Firmen beziehen. Darüber sollte man sich erstmal freuen. Erkenntnis ist durchaus hilfreich. Aber die vorgeschlagenen Konsequenzen sind im Moment doch sehr nebulös und dort, wo es konkreter wird, mitunter ziemlich abenteuerlich und manchmal auch sehr hilflos. Wir haben uns die neusten Strategiepapiere, die im Auftrag der deutschen Bundesregierung angefertigt wurden, genauer angeschaut.

Strategische Marktanalyse im Auftrag des BMI

Mitte letzten Jahres wurde der Abschlussbericht einer Marktanalyse, den das Bundesministerium des Innern, für Bau und Heimat beauftragt hatte, veröffentlicht. Unter dem Titel „Strategische Marktanalyse zur Reduzierung von Abhängigkeiten von einzelnen Software-Anbietern“ hat das Papier für viel Furore im Markt gesorgt. So sieht beispielsweise die Arbeitsgruppe KRITIS die „Digitale Souveränität des Staates gefährdet“. eGovernment Computing titelt „Die Bundesverwaltung ist abhängig von Microsoft“.

Der Bericht klammert im Bereich Unternehmenssoftware die Hersteller SAP und Oracle ohne größere Diskussion von der weiteren Betrachtung aus, weil diese Anwendungen angeblich „weniger stark eingesetzt werden“, stellt aber gleichzeitig fest „Die Bundesverwaltung ist in allen Schichten des Software-Stacks von wenigen Software-Anbietern stark abhängig. Das gilt besonders für Microsoft, …“.

Nicht, dass wir uns falsch verstehen, eine Marktanalyse darüber, welche Hard- und Software in deutschen Behörden und Unternehmen genutzt wird, wäre zweifellos wichtig. Aber hierzu gehören zum Beispiel auch der Hardwarebereich, weitere Software als nur Anwendungen für Bürokommunikation, Virtualisierung und natürlich Smartphones und deren Betriebssysteme. Diese Aspekte kommen im Bericht zu kurz. Gleiches gilt für das Thema Cloud-Computing.

Auch Betriebs- und Kostenaspekte werden nicht ausreichend beleuchtet. Bereits 2015 hatte dasselbe Ministerium das Projekt „IT-Konsolidierung Bund“ (IT-K Bund) gestartet. Ziel war (und ist) es, die über unzählige Ministerien und Behörden verteilten Kompetenzen und Ressourcen (unter anderem knapp 100 Rechenzentren und über 1.000 IT-Betriebsstätten) zusammenzuführen und zu bündeln. Ausgangspunkt damals war die Erkenntnis, dass die historisch gewachsenen dezentralen Strukturen und die so entstandenen unterschiedlichsten Anwendungen und Prozesse in einer modernen IT nicht hilfreich sind und eine übergreifende Kommunikation und Zusammenarbeit behindern. Gerade die föderale Struktur der Bundesrepublik, aber auch die Integration in europäische Strukturen, erforderten zwingend einheitliche Datenstrukturen und -formate und den Zugang zu gemeinsam genutzten In-

frastrukturen, so die damalige Position. Betriebsoptimierungen wie die Virtualisierung von Servern oder hyperkonvergente Infrastrukturen entfalten ihre Wirkung tatsächlich erst in mittleren bis großen Rechenzentren.

Ziele von „IT-Konsolidierung Bund“ sind unter anderem:

- Informationssicherheit,

- Flexibilität beim Einsatz neuer Technologien und

- ein leistungsfähiger, wirtschaftlicher, stabiler und zukunftsfähiger Betrieb.

Dies soll durch den Aufbau zentraler RZ-Infrastrukturen, der Bündelung aller IT-Beschaffungen bei zentralen Dienstleistern und der Entwicklung einheitlicher IT-Lösungen erreicht werden.

Die Frage ist berechtigt, wie vor diesem Hintergrund das Papier von 2019 zu beurteilen ist. Jedenfalls passen die Vorschläge im neuen Papier nur sehr bedingt zur geplanten technischen und wirtschaftlichen Konsolidierung von IT-K Bund. Das Papier von 2019 empfiehlt zur Reduzierung der Herstellerabhängigkeit im Wesentlichen drei Lösungsstrategien: verhandeln, diversifizieren und Open-Source-Software.

Die Idee, mit den Herstellern zu verhandeln, ist im Kern nicht schlecht, aber per se nur durch (sehr) große Organisationen umsetzbar. Microsoft, Google etc. werden kaum mit jedem Mittelständler über ihre Software diskutieren. Daher wäre es tatsächlich sehr zu begrüßen, wenn der Bund oder gar die EU auf die Hersteller zuginge und Anpassung hinsichtlich Transparenz, Einhaltung der DSGVO und Verbesserungen bei der Informationssicherheit einforderte – gegebenenfalls mit politischem Druck. Dass die Hersteller hier prinzipiell bereit sind, sich zu bewegen, hat sich in der Vergangenheit mehrfach gezeigt.

Der zweite Vorschlag ist mit „Diversifizierung mit proprietärer Software“ überschrieben. Eine Multi-Vendor-Strategie für Bürosoftware wird empfohlen. Das dürfte jedoch die Effizienz einer Organisation nicht gerade erhöhen. Auch das in 2015 initiierte Konsolidierungsprojekt des Bundes zielt ja wohl eher darauf, das Software-Portfolio von Bund und Ländern stärker zu standardisieren und zu vereinheitlichen als zu diversifizieren.

Beim Vorschlag, vermehrt Open-Source-Software (OSS) einzusetzen, werden Kosten- und vor allem Betriebsaspekte weitgehend ausgeklammert.

Welche Rolle spielt das Betriebssystem?

Über Betriebssysteme und die Abhängigkeit von ihnen wurde lange Jahre kontrovers diskutiert. Diese Diskussion wird möglicherweise durch zwei Entwicklungen an Relevanz verlieren: Mobilität und Cloud-Computing. Beiden ist gemeinsam, dass die Bedeutung des genutzten Betriebssystems zurückgedrängt wird: Es wird in der modernen IT zunehmend egal, mit welchem Endgerät unter welchem Betriebssystem ein Benutzer arbeitet!

- Mobilität

Mobilität wird in Zukunft zweifellos ein wesentlicher Baustein jeder IT-Architektur sein. Das klappt nicht mit Desktops, und auch Notebooks sind nicht für jedes Szenario geeignet.

Umgekehrt bieten Smartphones und Tablets durchaus eine technische Alternative zum klassischen Desktop. Diese Geräte können heutzutage zusammen mit einer Docking-Station und einem Monitor mit Blick auf die Rechenleistung einen Desktop-PC locker ersetzen. Zwar werden einige Softwareprodukte nach wie vor auf diesen Geräten nicht unterstützt, aber es stehen gerade im Bereich Bürosoftware mittlerweile sehr viele Apps zur Verfügung. Selbst Microsoft-Office-Anwendungen laufen unter iOS und Android. Der Vollständigkeit halber muss man an dieser Stelle aber anmerken, dass die Betriebssystemhersteller Google und Apple auch nicht gerade für ihre große Transparenz bekannt sind.

Wichtig ist festzustellen, dass mit dem Trend zu mehr mobilem Arbeiten und mobilen Endgeräten auch mehr Alternativen zu Betriebssystemen zur Verfügung stehen.

- Cloud-Computing

Moderne Software aus der Cloud ist per Design unabhängig von einem Betriebssystem. In der Regel muss die Software noch nicht einmal installiert werden, es genügt ein moderner Browser, in dem die Anwendung gestartet wird: keine Installation, keine Inventarisierung, keine verwalteten Updates.

Daher kommen hier Smartphones und Tablets mit Android oder iOS genauso in Frage wie spezielle Entwicklungen für Desktop-PCs, zum Beispiel ChromeOS: Auch durch Cloud-Computing entspannt sich die Abhängigkeit von Windows.

Die Rolle von Cloud-Computing untersuchen wir weiter unten detaillierter.