6. Beispiele

Wie schon erwähnt lassen sich die Einsatzszenarien für ein DPFS grob in zwei Bereiche einteilen: HPC und Virtualisierungslösungen. In diesem Abschnitt werden einige Produktbeispiele genannt und dargestellt. Dabei werden auch die primären Einsatzbereiche der jeweiligen Lösung kurz angesprochen. Alle Beispiele werden am Ende noch einmal gegenübergestellt.

Dabei sollte beachtet werden, dass es sehr viele DPFS gibt, die teilweise sehr unterschiedliche Anforderungen bedienen. Daher sind die hier aufgeführten Beispiele kein umfassender Vergleich der am Markt verfügbaren Lösungen. Das richtige DPFS für das eigene Unternehmen hängt von deutlich mehr Faktoren ab, als in diesem Artikel beschrieben werden können.

6.1 IBM Spectrum Scale (ehemals GPFS)

IBM Spectrum Scale ist das älteste am Markt verfügbare DPFS und bietet einen großen Funktionsumfang, der auf Anwendungen mit hohen Performance-Anforderungen zugeschnitten ist. Darunter fallen alle in Kapitel 4 aufgezählten zusätzlichen Funktionen mit Ausnahme von Deduplizierung.

Ein Alleinstellungsmerkmal von Spectrum Scale stellt die sehr umfangreiche Konnektivität sowohl zu Storage-Backends als auch zu Clients dar. Speziell die Unterstützung von Tapes als Storage-Backend ist hier bemerkenswert und kann in Verbindung mit Tiering zu Kostenersparnissen führen.

Bei der Anbindung von Clients über nicht-native Schnittstellen (Beispiele: NFS, SMB) verfällt aber ein Teil des Performance-Gewinns durch eine Bündelung von Zugriffen auf einen NAS-Kopf.

Hauptsächlich findet man Spectrum Scale im Umfeld von HPC, Big Data und im Bereich der Medienbearbeitung. Der Funktionsumfang erlaubt aber auch die Nutzung als (quasi-zentralen) Storage für andere Anwendungen.

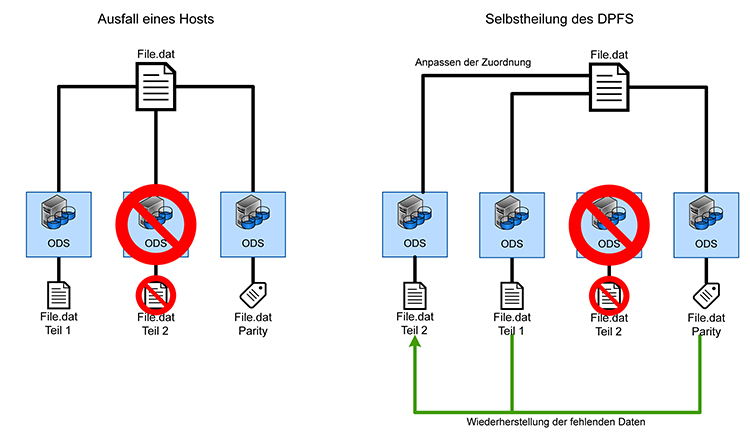

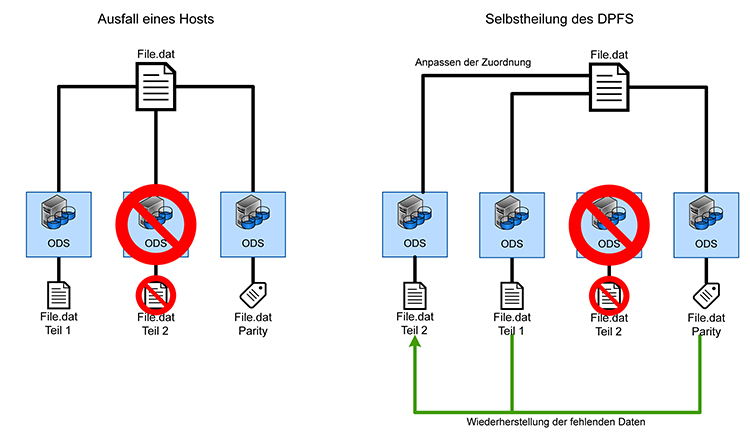

Abbildung 5: Selbstheilung eines DPFS

6.2 Lustre

Lustre, welches in den letzten Jahren maßgeblich von Intel entwickelt wurde und wird, bietet den geringsten Funktionsumfang unter den vorgestellten Lösungen und verlässt sich für Datenreduktion und Datenintegrität auf das zugrundeliegende Dateisystem. Hier findet man oft (Open)ZFS, da dieses die Funktionen von Lustre gut ergänzt. Thin Provisioning ist nicht vorgesehen, womit auch deutlich wird, dass das Einsatzszenario klar im HPC-Umfeld und nicht bei der Virtualisierung gesehen wird. Besonders sichtbar wird dies anhand der fehlenden nativen Windows-Unterstützung; ein Zugriff auf Lustre kann von Windows aus nur über SMB erfolgen, was zu einem indirekten Zugriff führt. Dadurch sind einige der großen Vorteile eines DPFS mit Lustre unter Windows nicht möglich.

Lustre selbst ist ein Open-Source-Projekt, wobei kommerzieller Support durch Intel verfügbar ist.

6.3 CephFS

CephFS bietet einen ähnlichen Funktionsumfang wie Spectrum Scale, ist aber ein jüngeres DPFS im HPC- und Big-Data-Umfeld. Es bietet ähnliche Anbindungsmöglichkeiten für Clients wie Spectrum Scale, mit denselben Einschränkungen. Daher sind auch die möglichen Einsatzszenarien ähnlich.

CephFS ist – wie Lustre – ein Open-Source-Projekt, wobei kommerzieller Support durch den Hersteller (Ceph) verfügbar ist.

6.4 VMware vSAN

VMware vSAN kann als Teil einer vCenter-Umgebung genutzt werden, um den direkt angeschlossenen Speicher der beteiligten Virtualisierungshosts effektiv zu nutzen. Es bietet einen ähnlichen Funktionsumfang wie zentralisierte Storage-Ressourcen; dabei können aber viele Funktionen auf Ebene einzelner virtueller Festplatten-Abbilder eingestellt werden. Redundanz kann dabei auch auf Ebene ganzer Bereiche erfolgen, deren Ausfall den Betrieb nicht beeinflussen soll (sog. Fault Domains). Diese können einzelne Hosts, Racks oder ganze Rechenzentren sein.

Ein Zugriff auf das vSAN ist mittlerweile über iSCSI auch für externe Systeme möglich und erlaubt so auch die Nutzung von vSAN als Ersatz für ein traditionelles SAN.

Das Einsatzszenario für VMware vSAN lag ursprünglich ausschließlich in der Nutzung durch die firmeneigene Virtualisierungsplattform. Zwar ist ein Zugriff von außen mittlerweile möglich, aber nicht weit verbreitet.

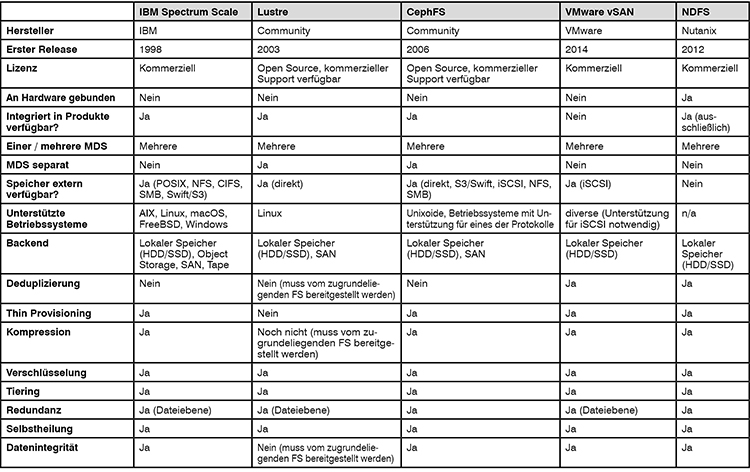

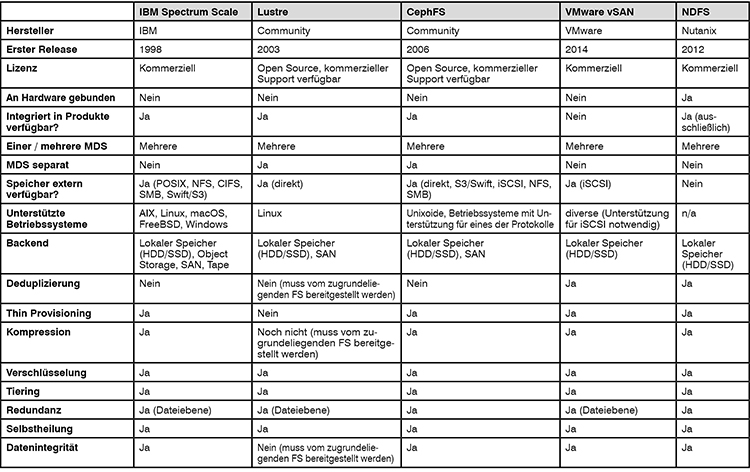

Abbildung 6: Gegenüberstellung

6.5 Nutanix Distributed Filesystem

NDFS wurde entwickelt von ehemaligen Mitarbeitern von Google, die die Architektur des bei Google genutzten „Google Filesystem“ (GFS) als Grundlage für ihr eigenes Dateisystem genutzt haben. Der Funktionsumfang ist quasi identisch zu VMware vSAN. Auch ist der Zielmarkt (HCI) derselbe. Allerdings wird ein etwas anderer Ansatz verfolgt:

Statt einer starken Integration in eine Virtualisierungsumgebung bietet NDFS eine weitgehend Hypervisor-unabhängige Implementierung. So werden die in einen Host eingebauten Festplatten an eine NDFS-Controller-VM „durchgereicht“, die als Storage in den eigentlichen Hypervisor (HV) eingebunden wird. So besitzt jeder Virtualisierungshost einen Server für NDFS, der die Verteilung der Daten mit den anderen im Cluster vorhandenen Servern koordiniert.

NDFS dient ausschließlich als Speicherplattform für eine Virtualisierungsumgebung. Andere Einsatzszenarien sind nicht vorgesehen.

Bei einem Vergleich mit vSAN muss auch hervorgehoben werden, dass Nutanix diese Technologie schon zwei Jahre vor Verfügbarkeit von VMware vSAN angeboten hat. Allerdings bietet Nutanix diese Technologie exklusiv in seinen eigenen HCI-Angeboten an, so dass eine Implementierung auf Hardware eines anderen Herstellers nicht möglich ist.

7. Zusammenfassung

Verteilte, parallele Dateisysteme haben sich von einer Nische im HPC-Bereich in den letzten Jahren immer mehr in Richtung des regulären Rechenzentrums bewegt. Dank der Verfügbarkeit von Ethernet mit Übertragungsraten von 10Gbit/s und mehr verfügen Clients und Server heutzutage über ähnliche Anbindungen, so dass eine zentrale Architektur an ihre Leistungsgrenzen stoßen kann. Hier bietet sich der Einsatz eines DPFS explizit an.

Für abgeschlossene Systeme, wie beispielsweise Testumgebungen oder bei der Nutzung von HCI, ist die Nutzung von zentralen Ressourcen entweder mit hohem Aufwand verbunden und ggf. nicht kompatibel mit vorhandenen Storage-Netzwerken (HCI). Oder man möchte aus Datenschutz- und/oder Sicherheitsgründen auf die Anbindung an den zentralen Storage verzichten. In diesen Fällen bieten sich DPFS ebenfalls an, da man ohne zusätzliche Infrastruktur den verfügbaren (direkt angebundenen) Storage der Systeme nutzbar machen kann, ohne teure RAID-Controller für eine ausreichende Redundanz zu benötigen.

Durch die enorme Performance von NVMe-SSDs ergibt sich außerdem die Herausforderung, dass bei Nutzung vieler solcher Speicher in einem einzelnen System schnell die verfügbare Bandbreite des Netzwerks erschöpft ist. Hier bieten DPFS eine elegante Möglichkeit, dass die Kapazität durch Verteilen auf viele Server nicht auf Kosten der Performance erhöht wird.

Durch die Verfügbarkeit von 100Gbit/s Ethernet sind auch hier neue Einsatzszenarien und –kombinationen möglich.

Mit der zunehmenden Verbreitung von Big Data und der steigenden Performance von Servern wird die Nutzung von DPFS für interne, performance-kritische Anwendungen immer interessanter, v.a. da keine Spezialhardware mehr notwendig ist. Es wird interessant werden, welche Formen von DPFS sich in welchen Bereichen durchsetzen werden und wie die Anbieter zentraler, monolithischer Storage-Lösungen darauf reagieren. Es bleibt zu hoffen, dass zwischen den Lagern ein Technologie- und Ideen-Austausch stattfinden kann, der das Beste aus beiden Welten vereinen kann.