KI-generierter Text kann eine Arbeitshilfe sein. Für belastbares Wissen muss man jedoch gezielt nachfassen. ChatGPT inklusive Browse bietet hierfür zukünftig „prominenter gezeigte“ Links – grundsätzlich eine gute Sache.

KI-basierte (Erst-)Informationen – nützlich, aber nicht blauäugig nutzbar

Eine mögliche Nutzungsweise von ChatGPT und ähnlichen Lösungen ist ein erleichterter Einstieg in neue Themen oder bestimmte Fragestellungen. Man kann bei Erstrecherchen Zeit sparen. Ein ausformulierter KI-Text macht den Zugang zu einem neuen Thema oder zu komplexen Details leichter als eine Suchmaschinen-Trefferliste zu ersten groben Stichworten.

Allerdings: Der angebotene Text kann nur so gut sein, wie die bei ihrer Generierung genutzten Informationen korrekt und aktuell sind. Schon wer „nur mal etwas über Thema XYZ wissen will“, sollte im Zeitalter von Fake-News usw. vorsichtig sein und weitere Quellen hinzuziehen. Beschäftigt man sich mit technischen Themen, muss man die Aspekte technischer Fortschritt und ständiger Erkenntnisgewinn berücksichtigen. Standards und Normen können kürzlich überarbeitet worden oder neu hinzugekommen sein. Hersteller können Default-Einstellungen zu Funktionalitäten geändert oder neue Empfehlungen für Default-Konfigurationen herausgebracht haben. Bestimmte Produkte können je nach Lizenz, Software-Variante etc. im Detail Neuerungen oder Unterschiede aufweisen.

Typische Probleme in der Nutzungspraxis von KI-generierten Texten:

- War die an die KI formulierte Fragestellung so präzise, dass die Antwort Unterschiede im Detail berücksichtigt?

Wer so genau fragen kann, muss schon solides Vorwissen haben und regelmäßig die wichtigsten „News“ verfolgen. - Ist die Informationsbasis, aus der die KI bei der Textgenerierung schöpft, so aktuell und umfassend, dass schon die neuesten Erkenntnisse und Entwicklungen enthalten sind?

Wo und wie kann man ansonsten weiter recherchieren?

Beispiel: Informationsgewinnung im IT-Alltag – für Planung, Betrieb, IT-Sicherheit

Bei Problem a) bin ich mir selbst gegenüber grundsätzlich bewusst misstrauisch. Bei b) ist schon der Vorgang einer soliden Qualitätssicherung vor der Aufnahme in die Informationsbasis unsicher. Diese erwarte ich von einer Informationsquelle, deren Auskünfte ich nicht mühselig in allen Details verifizieren müssen möchte. Hochaktuell und trotzdem seriös vorgeprüft – der entstehende Zielkonflikt versteht sich praktisch von selbst. Nur absolutes Grundlagenwissen bleibt sehr lange stabil, gerade bei IT-Themen. Das lehrt z. B. die langjährige Erfahrung aus Erstellung und Pflege von Unterlagen für Seminare und Vorträge zu IT-Themen.

Bei 1. und 2. gemeinsam scheitert man zudem gerade in der IT-Praxis oft am dynamischen Angebot von Lösungsoptionen. Welche Möglichkeiten zur Bestückung von Geräten gibt es aktuell? Welche Optionen für Firmware- oder Software-Pakete gibt es aktuell zu einer bestimmten Lösung? Wer Geld verdienen will, muss seine Produkte ständig weiterentwickeln und Neues anbieten. Open Source Communities reagieren noch agiler – wenn da jemand etwas vermisst, kann er seinen Lösungsversuch anbieten. Andersherum muss man auf der Suche nach Lösungen auch aufmerksam sein: Ist eine interessant klingende Produktvariante längerfristig noch verfügbar? Kann ChatGPT in einem Antwortvorschlag neueste EOL-Ankündigungen usw. bereits berücksichtigt haben?

Die Praxiserfahrung zeigt: Eine Recherche zum Kennenlernen und für ein erstes Verständnis von Optionen ist eine Sache. Eine andere: Muss ich es genau wissen, bevorzuge ich aus langjähriger Erfahrung die Informationsgewinnung an der Quelle. Das sind dann z.B. Herstellerinformationen mit Bezeichnungen wie Manual, Administration Guide, Security Guide, Knowledge-Base-Artikel mit Beschreibung einzelner Parameter oder Original-Standards und Normen, IETF-RFCs usw. Das ist eine erprobte Vorgehensweise zur Abklärung von Details, wenn es auf diese ankommt. Will ich eine mir vorgelegte Konfiguration verstehen und bewerten, einen störungserzeugenden Fehler oder eine Sicherheitsschwäche finden, hilft kein Stille-Post-Input aus der Suchmaschine. Will ich Möglichkeiten zum Umgang mit neuem oder besonderem Sicherheitsbedarf kennenlernen und ausloten, brauche ich einen erläuterten Satz an Einstellmöglichkeiten. Ein Konfigurationsbeispiel, das grundsätzlich funktioniert, hilft da nicht.

ChatGPT-Ankündigung: prominenter präsentierte Links in Browse-basiertem Text

Sofern ich ChatGPT (oder einen vergleichbaren Dienst) zu technischen Themen nutze, folgt dies typisch grob dem Schema: 1. Einstiegsfrage stellen – 2. Frage nach erster Antwort verfeinern – 3. irgendwann in eigene verifizierende und tiefere, an der Quelle nachfassende Recherche übergehen.

Die nachfassende Recherche nutzt dann Suchmaschinen bzw. die Suchfunktion zu Web-Sites, die als wichtige Quelle erkennbar wurden, wie etwa Hersteller-Webseite, Normen-Gremium, Web-Präsenz des Bundesamtes für Sicherheit in der Informationstechnik. Bei technisch anspruchsvollen oder detaillierten Fragestellungen ist das leider trotz der über Schritte 1. und 2. gewonnenen Einstiegsinformationen immer noch mühselig. Gefühlt ist man hier oft in einer modernen Aschenputtel-Situation. Bei schon länger verfügbaren Technologien kommt man sich gar vor wie ein Hausmeister, der nachträglich Müllcontainer auskippen und die Trennung neu vornehmen muss. Der Sortieralgorithmus für die Trefferliste der Suchmaschine passt oft nicht zum Informationsbedarf. Das ist schlecht – eigentlich hat man es ja eilig und möchte zu Informationen kommen, die man auswerten und erfolgreich weiterverwenden muss.

Eine gewisse Hilfestellung über erste gute Quellen-URLs, über die, deren Umgebung oder gar darin enthaltene Verweise man gezielter weitergraben kann, wäre da günstig.

Gerade unter diesem Gesichtspunkt habe ich ChatGPT seit einer Weile verfolgt und bewusst in einigen mir grundsätzlich geläufigen Themen auf die Probe gestellt.

Anfangs war der Erfolg solcher Tests zweifelhaft: Zumindest die kostenfreie Variante konnte man in der Frühphase mit einer einfachen Aufforderung zur Nennung von Quellen schlichtweg vergessen. Entweder kam gar nichts mehr zurück oder man flog sogar aus der Sitzung. Dies ließ sich reproduzieren. Wer Spaß daran hat, ein neues Angebot auf Schwächen zu untersuchen, nur um diese dann vorzuführen, mag das als Erfolg sehen. Meine Einschätzung damals war: „Schade, noch nicht …“. Vor Sicherheitslücken mag ich warnen, erkannte (vorläufige?) funktionale Einschränkungen sind kein Triumph.

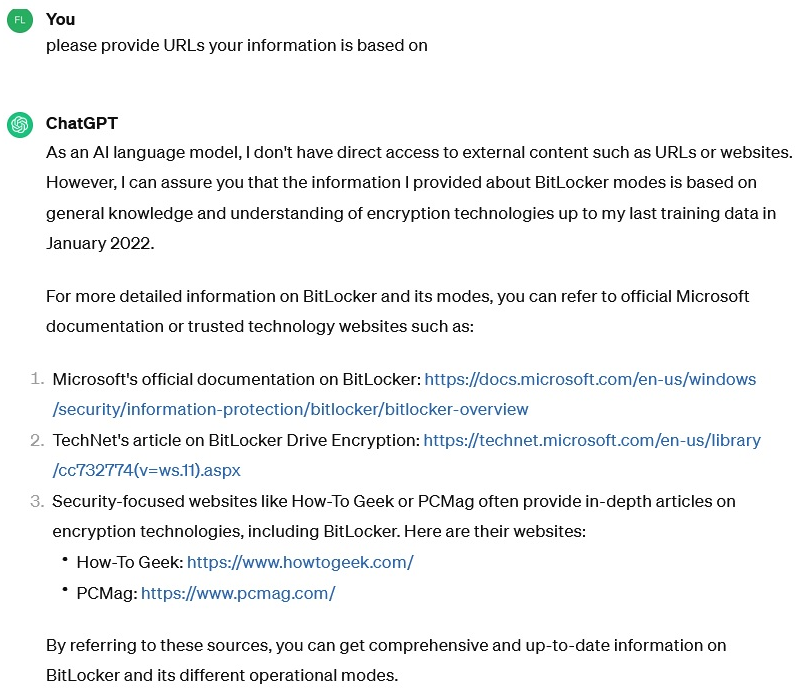

Mittlerweile bekommt man bei der bewusst (auch) getesteten kostenfreien Variante von ChatGPT zumindest Hinweise im Sinne der oben aufgeworfenen Problempunkte a) und b). Dem nachfolgenden Beispiel geht die Abfrage einer Erläuterung verschiedener Bitlocker-Verwendungsoptionen unter Sicherheitsgesichtspunkten voraus:

Schon besser, dabei natürlich unter Beschränkung auf das, was die kostenlose ChatGPT-Nutzung als Informationsbasis nutzen kann. Diese wird zu bestimmten Zeitpunkten gefüttert, kann anders als die kostenpflichtigen Varianten (Plus, Team, Enterprise) nicht per Browse-Option unmittelbar „auf eine Internet-Recherche geschickt werden“. Zumindest aber erhält man eine Aussage über den letzten Trainingszeitpunkt zur Informationsbasis (im Beispiel: vor mehr als zwei Jahren) und eine erste Hilfe für die weitere Eigenrecherche.

Verbesserungswürdig: Ich möchte nicht erst nach solchen Einstiegslinks fragen müssen. Die möge man direkt in den Text einbauen, z.B. Fußnoten-artig wie in Wikipedia-Artikeln oder ähnlichen statischen Informationsseiten.

Genau in diesem Sinne macht OpenAI jüngst eine Ankündigung, siehe https://twitter.com/OpenAI/status/1773738074041717109. Im dort gezeigten Beispiel unter der Überschrift „Making links more prominent in ChatGPT“ sind weiterführende Links unmittelbar in den Antworttext auf die gestellte Frage eingebaut. Die Spekulationen in Fachpresse-Artikeln, warum OpenAI den Schritt dieser erleichterten weiterführenden Recherche und Prüfung von Quellen geht, interessieren mich dabei nicht. Mir geht es um die Erleichterung meiner Arbeit genau beim Routine-Schritt zur Verifizierung und Vertiefung der angebotenen Informationen. In diesem Sinne ist das ein Fortschritt, den ich begrüße.

Natürlich muss man abwarten, wie gut solche Link-Angebote für die Themen sein werden, die einen selbst regelmäßig interessieren. Auch darf man übliche Sicherheitsbedenken nicht völlig vergessen – ist ein direkter Klick auf einen solchen Link im jeweiligen Fall unbedenklich? Hierzu gibt es bekannte Alltags-Lösungen: Übliche Sicherheitsempfehlungen wie „erstmal mit der Maus über den Link fahren und die URL prüfen“ oder „im Zweifel die URL im Browser abtippen“ kann man anwenden. Wer noch sicherer gehen will, nutzt eine besonders isolierte und abgesicherte Browser-Lösung. Das ist kein ChatGPT-spezifisches Sonderproblem bzgl. als Link angebotener Sprungziele, solange die ChatGPT-Nutzung nicht grundsätzlich an solchen Vorkehrungen scheitert.

Kleiner Wermutstropfen:

Das über die oben genannte OpenAI-Veröffentlichung angekündigte prominentere Präsentieren ist zumindest vorerst noch auf die Nutzung der Browse-Option, d.h. die kostenpflichtigen ChatGPT-Nutzungspakete beschränkt.

Vielleicht tut sich da noch etwas auch für die kostenlose Variante, im Sinne von URL-Informationen wie im obigen Bild gezeigt. Wer darauf nicht warten möchte, aber die kostenfreien KI-Informationsangebote mit solcher Erleichterung bzgl. URL-Informationen aus „trainierten“ offline-Textbeständen nutzen möchte, muss ChatGPT-Alternativen bzgl. entsprechender Optionen im Auge behalten. Allerdings sollte man dabei auf dem Teppich bleiben: Kostenlos, mit allen neuesten Features „am Markt“ versehen sowie hochaktuelle Informationsbasis? Irgendwo wird da jeweils ein Kompromiss im Spiel sein. Den muss man dann für sich selbst und die eigenen Recherchethemen prüfen und bewerten.