Sollten Sie noch nicht in unserem Informationsverteiler sein, können Sie sich gerne hier kostenlos anmelden

Konsolidierung im Rechenzentrum weitergedacht – Converged und Hyperconverged Infrastructure

Automation und Betriebsoptimierung sind die großen Themen in unseren Rechenzentren. Der erste wichtige Schritt war die Virtualisierung von Servern. Um die beiden anderen Bereiche Storage und Netzwerk ebenfalls auf eine virtualisierte Ebene zu heben, stehen mittlerweile seitens der Hypervisor-Hersteller leistungsfähige Tools zur Verfügung. Damit ist das sogenannte Software-defined Datacenter (SDDC) in greifbarer Nähe. Was ist aber mit der zugrunde liegenden Hardware? Ja, die Hersteller von Servern oder Netzwerkkomponenten bieten Verwaltungswerkzeuge für ihre Produkte an, aber letztlich wird damit die Silostruktur vieler Betriebsorganisationen nur weiter zementiert, statt – im Sinne der anwendungsorientierten Gesamtsteuerung des SDDC – die strikte Trennung aufzuweichen und zu mehr Zusammenarbeit zu kommen. Sogenannte Converged- und Hyperconverged-Lösungen versprechen hier Abhilfe: Integrierte und vorkonfigurierte Gesamtkonzepte für Compute, Storage und Netzwerk aus einer Hand. Doch nicht jede Lösung ist für jedes Umfeld geeignet. Wir geben in diesem Artikel einen Überblick über CI- und HCI-Lösungen und zeigen beispielhaft, wo Einsparungen und Betriebsoptimierungen liegen können.

Web Security aus der Cloud: Eine langfristige Option oder experimenteller Hype?

Die Absicherung des Internetzugriffs für Mitarbeiter eines Unternehmens nimmt einen hohen Stellenwert in der Informationssicherheit ein. Dazu verfolgen verschiedene Appliances das Ziel, den Nachrichtenverkehr auf Schadcode zu inspizieren bzw. dafür zu sorgen, dass unternehmensweite Richtlinien wie verweigerte Zugriffe auf verbotene Webseiten durchgesetzt werden. In den vergangenen Jahren etablierten sich hierzu Lösungen, die auf einer Cloud Infrastruktur aufsetzen und dem Unternehmen verschiedene Vorteile finanzieller und technischer Natur versprechen. Ob solche Lösungen ein innovativer Schritt Richtung Zukunft sind oder sich der Trend womöglich als „Eintagsfliege“ herausstellen könnte, soll in diesem Artikel besprochen werden. Zusätzlich werden Schritte vorgestellt, die bei der Einführung einer solchen Lösung aus der Cloud beachtet werden sollten.

Timo Schmitz

ComConsultCloud First – und dann?

In vielen Unternehmen gibt es mittlerweile die Vorgabe „Cloud First“. Dies bedeutet, dass zumindest bei jeder Neuentwicklung bzw. Neuplanung die Cloud bevorzugt wird. Unabhängig von der Sinnfälligkeit einer solchen Vorgabe muss eine Reihe von Fragen geklärt werden. Um welche Fragen geht es? Was sind die Antworten darauf?

Dr. Behrooz Moayeri

ComConsultHerausforderung 5G Security

Die 5. Generation des Mobilfunks (5G) materialisiert sich nun immer sichtbarer, die Provider beginnen mit dem Ausbau und versorgen schon erste Bereiche, und Endgeräte sind, wenn auch nur eine bescheidene Auswahl, ebenfalls verfügbar. 5G verspricht dabei viel: Sehr hohe Datenraten, Versorgung des Internet of Things (IoT) vom Smart Home bis zur Smart Factory in der Industrie 4.0, von Vernetzung von Fahrzeugen bis zur Funkversorgung für autonome Fahrzeuge. Auf der einen Seite wird 5G im IoT-Bereich also einen Massenmarkt versorgen, aber auch auf der anderen Seite hochkritische Anwendungen, bei denen ein Sicherheitsvorfall durchaus lebensgefährliche Folgen haben kann. Außerdem werden beispielsweise Anwendungen in der Automatisierungstechnik adressiert, deren Echtzeitanforderungen mit konventionellem WLAN nicht gut genug bedient werden.

Dr. Simon Hoff

ComConsultCloud First – und dann?

Fortsetzung

In meinem letzten Geleit [1] plädierte ich dafür, Cloud Computing geregelt zu nutzen und nichts dem Zufall zu überlassen. Anlass war meine Feststellung, dass die Entwicklung und Planung für die Cloud in einigen Unternehmen ein Eigenleben entwickelt hat. Dieses Eigenleben kann zu einer dualen IT führen, mit anderen Regeln als die IT-Umgebungen „on premises“ (OnPrem), also im eigenen Rechenzentrum. Dafür habe ich die Beispiele Zonenkonzept und Perimeter genannt. Hier möchte ich auf ein paar andere Themen im Zusammenhang mit der Cloud-Nutzung eingehen.

Bleibe ich der uneingeschränkte Herrscher über meine Daten?

Diejenigen, die sich in der eigenen IT-Infrastruktur mit der Sicherung und Wiederherstellung von Daten befasst haben, wissen, dass es dabei sehr komplexe Probleme geben kann. Mit der Cloud kommen neue Probleme dazu.

Der Klassiker, der jede Organisation betreffen kann, ist die Herrschaft über die Daten im Zusammenhang mit Kommunikation und Teamarbeit.

Seit Jahrzehnten nutze ich die Kombination aus einer strukturierten Dateiablage und E-Mails, die ich ebenfalls strukturiert aufbewahre. So war ich neulich in der Lage, die Historie der Zuweisung unseres IP-Adressraums anhand von E-Mails aus den 1990er Jahren nachzuvollziehen. An dieser Stelle habe ich nicht vor, auf die Nachteile meines sicher persönlich geprägten Datenmanagements einzugehen (etwa auf die Schwierigkeiten, die meine Kollegen mit meinen Datenablagen haben werden, sollte ich plötzlich ausfallen und auch nicht ansprechbar sein). Fakt ist, dass sich heute meine Daten nicht mehr ausschließlich in Dateien, E-Mails und OnPrem-Datenbanken befinden. Im Zusammenhang mit der Organisation von Seminaren, Kongressen und anderen Veranstaltungen der ComConsult Akademie werden Daten generiert, die nur zum Teil als Dateien vorliegen. Zum Beispiel wird einiges in Chats abgestimmt. Da Kommunikation und Teamarbeit zunehmend in der Cloud stattfinden, landen die Chat-Daten dort.

Die Fragen bezüglich Datensicherheit und Datenschutz möchte ich an dieser Stelle ausklammern, wie wichtig sie auch sind. Eine andere Frage ist ebenso wichtig, nämlich die Frage nach der uneingeschränkten Kontrolle über die Daten. Meine E-Mails liegen in uns wohl bekannten und von uns beherrschten Ablagen. In diesen Ablagen finde ich notfalls 30 Jahre alte Daten. Sie sind mehrfach gesichert und von einzelnen Speichermedien sowie einzelnen Speicherorten unabhängig. Gilt das auch für die Chat-Daten?

Die unangenehme Antwort auf diese Frage ist ein klares Nein. Wer zum Beispiel Microsoft Teams nutzt, muss zumindest bisher damit rechnen, dass die Chat-Daten nicht einfach aus der Microsoft Cloud exportiert werden können. Der Kunde ist damit kein uneingeschränkter Herrscher über seine Daten. Kann ich darauf setzen, dass meine Nachfolger*innen in 30 Jahren nachvollziehen können, was ich heute in Chats vereinbare? Nein. Verbindliches mit solch langer Wirkung muss ich anderweitig dokumentieren. Niemand kann garantieren, dass es die Microsoft Cloud in 30 Jahren noch gibt.

Sind Cloud-Kosten beherrschbar?

Die Motivation vieler Unternehmen für die Cloud-Nutzung ist die Wirtschaftlichkeit. Wir müssen jedoch immer wieder feststellen, dass die Entscheidung für die Cloud nicht auf Basis einer vollständigen Kostenbetrachtung erfolgt. Wenn eine OnPrem-Applikation durch eine Cloud-Anwendung ersetzt wird, müssen wir die Kosten für den Zugang zur Cloud berücksichtigen. Uns bekannte Unternehmen erhöhen dafür die Bitrate ihres Internet-Zugangs in signifikantem Maße. Aber auch die Rechnung, die ich vom Cloud-Betreiber bekomme, kann sehr hoch ausfallen. Die Preismodelle in Clouds können durchaus komplex und unübersichtlich sein. Die Kette aus Speicherung, Verarbeitung und Übertragung von Daten in der Cloud verursacht an verschiedenen Stellen Kosten. Auf den ersten Blick scheinen diese Kosten geringfügig zu sein, weil sie oft feingranular pro GB und Stunde angegeben werden. Aber das Jahr hat 8760 Stunden, und meine Datenmengen können hunderte bis tausende Gigabytes groß sein!

Kostenkontrolle ist für die Cloud anders als OnPrem. Wir kennen die Kostenkomponenten in der eigenen IT-Infrastruktur ziemlich gut. Eine Berechnung der Total Cost of Ownership (TCO) einer Lösung im eigenen RZ ist nicht trivial. Aber darin sind wir geübt. Wir haben Erfahrung in der Schätzung und Feststellung von Kosten für Hardware, Service, Lizenzen, Raummiete, Kühlung, Energie, Betrieb etc. Nun müssen wir wissen, was ein virtueller Prozessor in der Cloud jährlich kostet, wie viel wir auf welchem Cloud-Speicher pro MB und Jahr bezahlen müssen, welche Kosten ein Internet Gateway in der Cloud verursacht, wie teuer die Datenübertragung zwischen verschiedenen Cloud-Regionen ist usw. Eine wichtige Übung jedes Ingenieurs ist die Kostenschätzung. Darin sind wir, was die Cloud betrifft, noch kaum geübt.

Umso wichtiger ist eine Kostenkontrolle im engen Zeitraster, zumindest täglich. Wir kennen Kostenbremsen zum Beispiel bei der Mobilfunknutzung. Habe ich mein monatliches Datenkontingent aufgebraucht, surfe ich bis zum Monatsende mit angezogener Handbremse. Solche Mechanismen sind in der Cloud entweder nicht verfügbar oder nicht gewünscht. Um böse Überraschungen zu vermeiden, muss man häufig in die Kostenübersicht der Cloud-Konsole hineinschauen. Stelle ich explodierende Kosten fest, muss ich auch noch schnell herausfinden, auf welche Änderung die steigenden Kosten zurückzuführen sind.

Zusätzlich erforderlich ist eine kostenbewusste Planung und Entwicklung für die Cloud. Mein Kollege Schaub hat in einem Artikel anhand von Beispielen dargestellt, wie eine kostenbewusste Entwicklung für die Cloud aussehen kann [2].

Wie ist die Performance einer Anwendung in der Cloud?

Wie schon erwähnt, bedeutet die Verlagerung einer Anwendung in die Cloud höhere Anforderungen an die Übertragungskapazität der Verbindung zur Cloud. Aber neben Bitrate gibt es einen weiteren wichtigen Faktor, der die Performance einer Anwendung in der Cloud bestimmt. Ich meine die Latenz.

Die Umstellung auf die Cloud kann bedeuten, dass Datenbewegungen, die bisher innerhalb eines Rechenzentrums stattfanden, nunmehr zwischen weit entfernten Standorten erfolgen. Mit „weit entfernt“ meine ich hunderte bis tausende Kilometer entfernt. Rechnet man mit ca. 200.000 km/s für die Lichtgeschwindigkeit in Glasfasern, bedeuten 200 km Kabelweg eine Latenz von 0,001 Sekunde, d.h. einer Millisekunde (ms). Eine Millisekunde Round Trip Delay (RTT, d.h. die Dauer der Datenreise hin und zurück) entspricht daher einem Kabelweg von 100 km zwischen zwei Standorten.

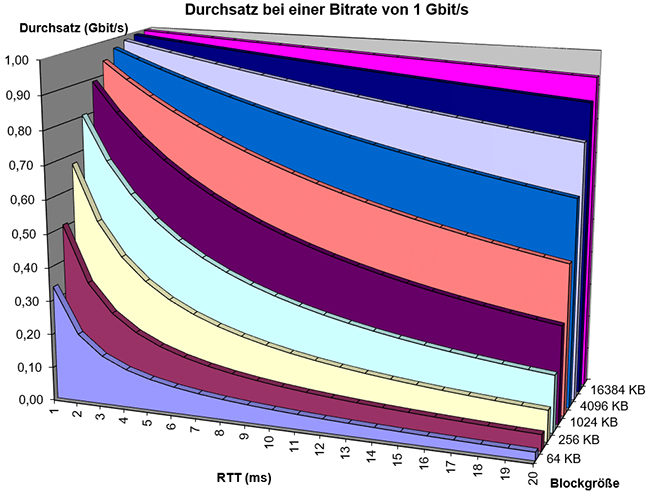

Der RTT-Wert ist somit abhängig vom Kabelweg zur Cloud. Der Kabelweg zur Cloud ist aber nicht nur von der Luftlinie zum Cloud-RZ, sondern auch davon abhängig, wie das Netz und die Kabeltrassen auf dem Weg zur Cloud aussehen. Die Auswahl des Netzbetreibers (Internet Service Provider oder WAN-Provider) hat also entscheidenden Einfluss auf die RTT-Werte zwischen meinem RZ und der Cloud. Dem Autor ist ein Szenario bekannt, in dem der RTT-Wert zwischen einem RZ und einer Cloud in der Infrastruktur des Providers A ca. 4 ms und in der des Providers B ca. 14 ms beträgt. Muss ich größere Datenmengen zwischen meinem RZ und der Cloud bewegen, zum Beispiel für Backup, dauert es beim Provider A weniger als beim Provider B. Latenz hat nämlich Einfluss auf den Durchsatz. Der Grund ist, dass eine Anwendung immer eine bestimmte Datenmenge überträgt (nennen wir sie einen Block), bevor eine Wartezeit eintritt, in der Höhe des RTT-Wertes. Es wird auf die Anforderung des nächsten Blocks gewartet bzw. auf die Bestätigung des Empfangs des gerade gesendeten Blocks. In der Abbildung 1 ist die Abhängigkeit des Durchsatzes vom RTT-Wert einerseits und von der Blockgröße andererseits dargestellt.

Abhängigkeit des Durchsatzes vom RTT-Wert und von der Blockgröße

Nehmen wir als Beispiel eine Blockgröße von 1 MB (1024 KB). Bei einer Bitrate der Leitung von 1 Gbit/s und einem RTT-Wert von 4 ms kann die Anwendung einen Durchsatz ca. 670 Mbit/s erreichen. Beträgt unter sonst gleichen Bedingungen der RTT-Wert 14 ms, sinkt der Durchsatz auf 370 Mbit/s. Die Datenübertragung dauert also um 80% länger. Die Auswahl des Providers hat also Einfluss auf die Performance bei der Cloud-Nutzung.

Viele Fragen im Zusammenhang mit der Cloud

Neben den in diesem und im letzten Geleit erwähnten Fragen bezüglich des Zonenkonzeptes für die Cloud, der Gestaltung des Perimeter-Bereichs, der Datenhoheit, der Kosten und der Performance der Cloud beschäftigen sich Unternehmen mit einer Menge anderer Fragen im Zusammenhang mit der Cloud, zum Beispiel mit den folgenden:

- Brauchen wir Fog- bzw. Edge-Computing als Cloud-Ergänzung?

- Wie sieht ein Service-Monitoring für Cloud-Anwendungen aus?

- Lohnt sich die Nutzung einer Co-Location für Anbindungen an Clouds?

- Worauf muss man bei der Authentisierung und Autorisierung für die Nutzung von Cloud-Anwendungen achten?

- Was sind die aktuellen rechtlichen Themen rund um Datenschutz und Datensicherheit für die Cloud?

Wenn Sie diese und andere Fragen im Zusammenhang mit der Cloud interessieren, empfehle ich Ihnen die Teilnahme an unserem Cloud Forum vom 25. bis 26. November 2019 in Köln.

Verweise

[1] „Duale IT: Fluch oder Segen?“ in Netzwerk Insider, September 2019.

[2] https://www.comconsult.com/cloud-preiswert-teuer/

Hallo zusammen,

Ich möchte zu diesem Thema einige Anregungen geben, die meine persönliche Meinung und Erfahrungen widerspiegeln. Ich spreche hier nicht für meinen Arbeitgeber

ich finde es immer wieder schade, das beim Thema TCO von Cloud-Anwendungen das Thema Schnittstellen Cloud on-Premise-Welt gar nicht oder nur unzureichend behandelt wird. Gerade für große Unternehmen ist eine Cloud-Only-Strategie nicht von heute auf morgen umsetzbar, sondern üblicherweise ein langjähriger Prozess. Tatsächlich werden wir ja auf absehbare Zeit vor allem ein Hybrid-Cloud-Szenario haben. Die Cloud-Anwendungen müssen mit irgendwelchen lokalen Anwendungen Daten austauschen können. Damit landen wir sofort beim Thema API-Management. Besonders Berater blenden das sehr oft aus und tun dann so als könnte man die Cloud wie eine Verlängerung des LAN behandeln. Das halte ich für sehr fahrlässig. Ein weiterer Aspekt, der oft nur unzureichend betrachtet wird, ist, dass auch Cloud-Infrastrukturen betrieben werden müssen. Je nach Cloud-Variante muss es ja hier auch Thema shared responsibility beachtet werden. Auch der Cloud-Kunde muss sich um Betriebsthemen auf seiner Seite kümmern, das darf nicht unter den Teppich gekehrt werden, weil das auch jeden Business-Case maßgeblich beeinflussen kann.

Das ist alles mit Kosten verbunden, die über die reinen Kosten für die Cloud-Ressourcen selbst und die Bandbreiten irgendwelcher Internet-Anbindungen u.U. weit hinausgeht. Meiner Meinung nach müssten solche Aspekte viel stärker herausgestellt werden, wenn es um eine realistisches Bild von Cloud-Kosten gehen soll.

Guten Tag Herr Herzog,

vielen Dank für Ihre sinnvollen Anregungen. Oft wird im Zusammenhang mit der Cloud der „Betrieb“ reduziert auf den Hardware-Betrieb, der in der Tat vom Cloud-Betreiber übernommen wird. Aber auch im eigenen RZ ist der Hardware-Betrieb nur ein kleiner Teil der vielfältigen Betriebsaufgaben. Wenn ich bei AWS oder Azure Compute-Instanzen, Speicher und VPCs bzw. VNETs anmiete, dann hört die Zuständigkeit des Cloud-Anbieters mit der Bereitstellung dieser virtuellen Ressourcen auf. Neben dem von Ihnen erwähnten wichtigen Aspekt des Betriebs der Schnittstellen zu Systemen im eigenen RZ bleibt eine ganze Reihe von anderen Betriebsaufgaben, um die ich mich kümmern muss: viele Sicherheitsaufgaben wie Härtung, Zonenbildung, Logging etc. und die zunehmende Komplexität dadurch, dass ich – wie von Ihnen erwähnt – eine duale IT (Cloud und OnPrem) bekomme, die in einigen Fällen sogar eng verknüpft ist. Wenn man Cloud Computing sicher und zuverlässig nutzen will, bringt es keine oder kaum Kosteneinsparung. Dies gilt auch für Software as a Service, einen Dienst, der den Cloud-Kunden am meisten entlasten soll. Wir brauchen Antworten auf Fragen wie Exit-Strategie, Sicherung der Daten außerhalb der Cloud etc.

Mit freundlichen Grüßen

Behrooz Moayeri