aus dem Netzwerk Insider Dezember 2023

Vor ca. 1 Jahr hat der Autor einen Artikel zur IT-Verkabelung veröffentlicht, bei dem es um die Anwendung der Norm EN 50600 ging und in dem an Beispielen gezeigt wurde, welche Idee der Norm zugrunde liegt, welche Vorgaben die Norm macht und wo es Interpretationsspielräume gibt. In einem Teil wurde kurz ein relativ unbekanntes Element zum Aufbau einer Verkabelung vorgestellt, die Norm nennt es den „Zwischenverteiler“. Diesen Zwischenverteiler sieht die Norm als optionales Element in einer hierarchischen Verkabelung vor. Er kann auf unterschiedliche Arten aufgebaut werden, eine davon ist die Bildung eines „zentralen Rangierortes“. Der nachfolgende Artikel erklärt, in welcher Form die aktuellen Normen dieses Teilelement vorsehen, wie es aufgebaut werden könnte, welche technische Varianten es gibt, und wann es auch bei Ihrer Planung sinnvoll sein könnte, dieses Element zu realisieren.

Standardverkabelung im Serverraum

Was ist eine Standardverkabelung im Sinne von „so machen es die meisten“? Hier können nur die subjektiven Erfahrungen des Autors im Rahmen der Beratungen, Fachplanungen und Seminartätigkeiten wiedergegeben werden, dies muss natürlich nicht repräsentativ sein. Doch vielleicht findet sich der ein oder andere Leser wieder. Vor allem ältere Standardverkabelungen

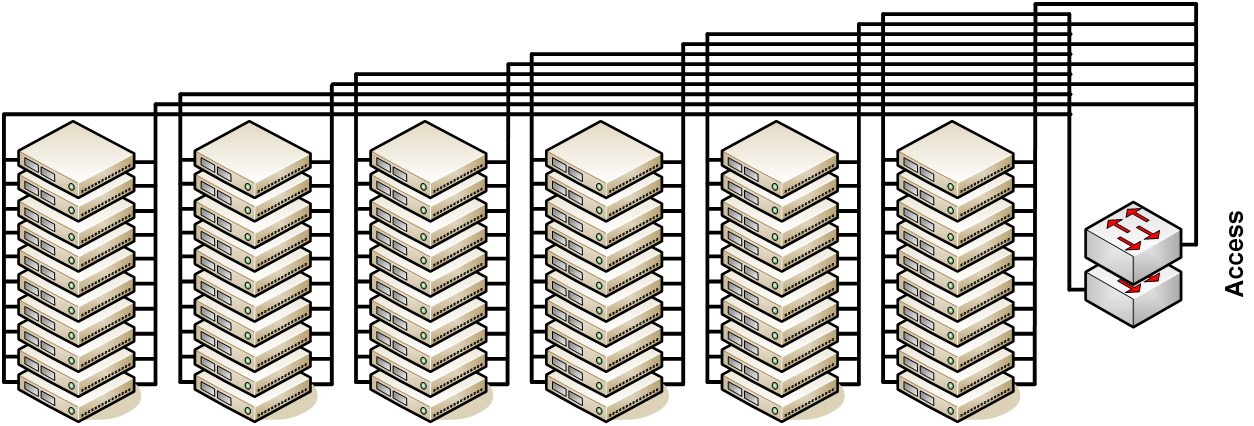

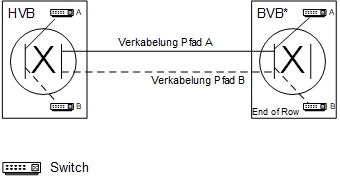

Abbildung 1: Beispiel einer EoR-Architektur

- berücksichtigen nicht die Begrifflichkeiten der Normen, denn nicht allen IT-Verantwortlichen sind Begriffe wie z. B. Hauptverteiler bekannt,

- haben häufig keinen hierarchischen Aufbau in Form von Sterntopologien,

- trennen eher nach Netzwerk- und Serverracks – sowohl begrifflich als auch in der Planung –,

- wurden nicht nach einer vorausgehenden Anforderungsanalyse entworfen, d.h. mit Festlegung der benötigten Übertragungsverfahren, Medien und anschließender Ableitung der Kabeltypen,

- sehen eine Verkabelung vor, die bei und zu jedem Rack anders ist, eine Einheitlichkeit wurde nie angestrebt,

- lösen häufig nicht die Problematik der hohen Mengen an Anschlussschnüren und unterschiedlichen Längen derselben,

- wurden nicht wirklich in Anlehnung an die Normen geplant.

Es gibt demzufolge Racks, in denen vorwiegend Netzwerk-Komponenten positioniert werden und Racks, in denen vorwiegend Server positioniert werden. Das sind dann klassische zentrale Lösungen oder abgestuft mit Komponenten in den Positionen Middle-of-Row (MoR) bzw. End-of-Row (EoR). Wurden die Server-Access-Switches zusammen mit den Servern in Racks montiert, spricht man von Top-of-Rack (ToR). Diese 3 Arten werden in der ursprünglichen Norm EN 51073-5 überhaupt nicht erwähnt, in der EN 50600 werden sie im Anhang ausführlich erläutert (siehe Abbildung 1).

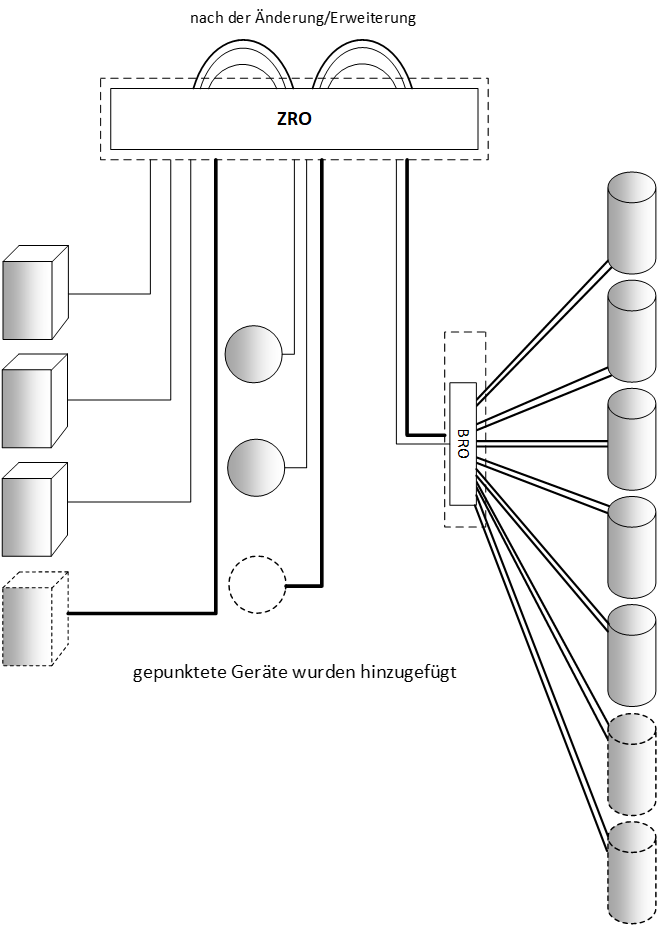

Abbildung 2: Schrankschema bei einer EoR-Lösung

Bei den eher zentralen Lösungen ist es üblich, dass eine Datenverkabelung von den Serverracks aus zu den zentral im Raum positionierten Netzwerk-Schränken vorgesehen wird. Je nach Größe des Serverraums bzw. Anzahl der Server-Racks werden dazu lange Anschlussschnüre verwendet – besser ist eine strukturierte Verkabelung, d.h. Kabel schließen mit Buchsen ab. Zwischen den Netzwerk-Schränken wurde noch eine Datenverkabelung zum Aufbau des Backbones vorgesehen, und „fertig ist die Verkabelung“.

ToR ist noch etwas einfacher: Die Anbindung der Server an die ToR-Switches erfolgt innerhalb des Racks mit kurzen Anschlussschnüren, und die strukturierte Verkabelung beschränkt sich im Wesentlichen auf die Backbone-Verkabelung zur Vernetzung der Switches. Natürlich gibt es auch Mischformen in unterschiedlichen Ausprägungen. Jedoch haben diese sehr häufig mit dem Ideengut der Normen wenig zu tun (siehe Abbildung 2).

Worin besteht denn jetzt der grundlegende Nachteil dieser Herangehensweise, die natürlich sehr oft so „historisch gewachsen ist“? Zum einen natürlich darin, dass nicht klar erkennbar oder festlegbar ist, ob eine solche Verkabelung irgendeinem Standard entspricht oder gar einer Verfügbarkeitsklasse. Zum anderen zeigt sich, dass bei fehlender Strukturierung das Maß an speziellen Nachverkabelungen sehr hoch ist, jedes Rack wird anders verbunden. Wenn diese dann noch mangelhaft dokumentiert sind, fehlt jede Transparenz. Änderungen durch Erweiterungen von neuen Racks oder durch Wegfall von vorhandenen werden erheblich erschwert bzw. unmöglich gemacht. Genau da setzen die aktuellen Normen an.

Zunächst erfolgt eine zusammenfassende Betrachtung der aktuellen Standards (bei weiteren Vertiefungen sei auf den genannten Artikel des Autors in der Ausgabe 12/2022 verwiesen).

Standardisierte IT-Verkabelung

Die älteste europäische Norm zur Beschreibung einer IT-Verkabelung in Rechenzentren ist die EN 50173-5, der erste Entwurf wurde 2017 veröffentlicht und existierte somit bereits vor der EN 50600-2-4 (erster Entwurf 2018). Letztere hat dann viele Ideen und Spezifikationen übernommen, verweist immer wieder auf die ältere EN 50173 und wird in der Zwischenzeit als DIE Norm zur Planung von IT-Verkabelungen verwendet.

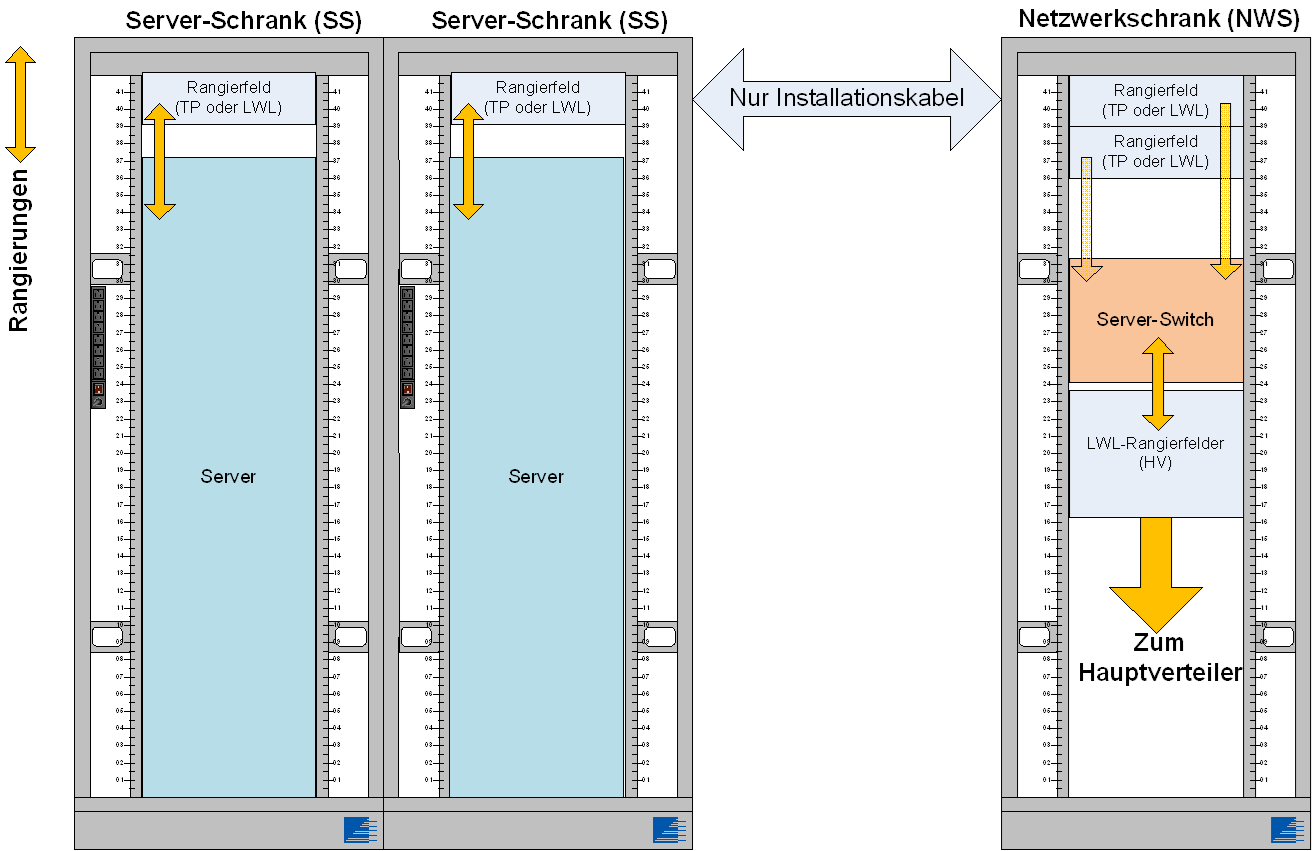

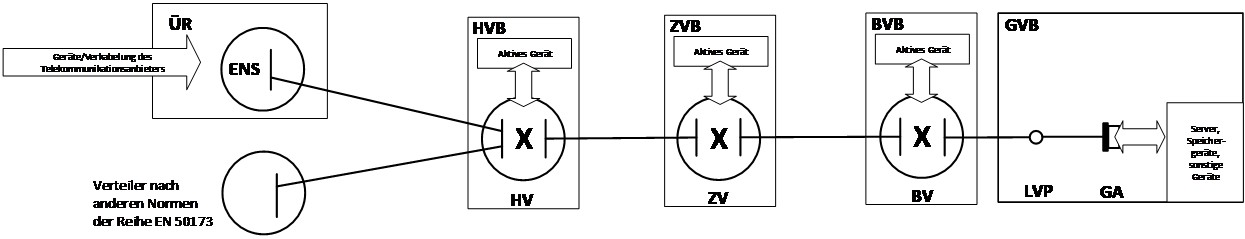

Abbildung 3: Normative Festlegung der Verteilerbereiche

Der grundsätzliche Ansatz beider Normierungen hat es geschafft, eine Verkabelungsinfrastruktur einzuführen, die in Abhängigkeit vom Bedarf unterschiedlich skalierbar ist und vielfältige Qualitätsklassen zulässt. Erst durch Standardspezifikationen innerhalb dieser Normen wird dem Planer bzw. Nutzer eine Stabilität und Sicherheit gewährleistet, welche zu einer hohen Nutzungsdauer der Verkabelungen führen wird. Ein Erfolgsgeheimnis der Standards besteht einfach ausgedrückt aus zwei Prinzipien, und zwar der Spezifikation von Verkabelungsteilelementen und der Empfehlung – nicht Vorschrift! – zur Verknüpfung der Teilelemente in bestimmten Topologievarianten.

Der Gegenstand des Artikels ist der „Rangierort“, deshalb wird zunächst beschrieben, was dieses Element den Normen nach ist und wo es in der Verkabelungstopologie eingesetzt werden soll. In der EN 50173-5 existiert diese Einheit nicht, erst mit der EN 50600 wurde das Element eingeführt. Man spricht vom „zentralen Rangierort“ und „Bereichsrangierort“. Die Bezeichnungen lassen bereits erkennen, wo der Einsatzschwerpunkt gesetzt wird, dazu muss man sich allerdings die unterschiedlichen Verkabelungsbereiche eines Rechenzentrums nochmals vor Augen halten:

Die Knotenpunkte der unterschiedlichen Verkabelungsebenen werden „Verteilerbereiche“ genannt. Sie stellen einen Bereich dar, das kann ein einzelnes Rack oder eine Rack-Gruppe sein. In der älteren EN 50173 spricht man nur von „Verteilern“, was vermutlich sehr oft dazu führte, dass man diese Funktion gezielt einem Rack zugewiesen hat, in der EN 50600 hat man dies geändert.

Abbildung 4: Detaildarstellung (Verteilerbereiche mit aktiven Komponenten)

Im Verteilerbereich befinden sich Racks, die Kabelenden der festen Verkabelung aufnehmen (in der Regel aufgelegt auf Rangierfelder), und es können zusätzlich aktive Systeme wie Switches vorgesehen werden, dies macht ein Auszug aus einer Grafik der Norm deutlich (siehe Abbildung 3).

Ein Bereichsrangierort, kurz BRO, kann sich im Bereichsverteilungsbereich befinden und ist daher eine spezielle Konfiguration eines Bereichsverteilers in Übereinstimmung mit der Verkabelung nach EN 50173-5. Ein zentraler Rangierort, kurz ZRO, kann sich analog dazu im Hauptverteilerbereich oder Zwischenverteilerbereich befinden. Damit gibt es 3 mögliche Positionen für Rangierorte.

Was ist jedoch ein „Rangierort“? Man kann es schon vermuten: Es ist ein passiver Rangierverteiler, also ein Verteiler, der keine aktiven Komponenten beinhaltet. Da der Rangierort eine „spezielle Konfiguration“ ist, trifft man bereits bei der Planung die Entscheidung, wie man die genannten Verteilungsbereiche gestaltet, mit oder ohne aktive Systeme. Man trifft eine Entscheidung, wie die Schränke, Rahmen oder Gestelle genutzt werden sollen.

Soll die EN 50600-2-4 eingehalten werden, so hat man bei einer geforderten Verfügbarkeitsklasse 1 die Wahl, ob man diese Rangierorte einsetzen will oder nicht. Ab VK2 jedoch nicht mehr, Zitat: „… damit die Auslegung für schnelle Umzüge, Erweiterungen und Veränderungen ausreichend flexibel und skalierbar ist, müssen zentrale und lokale Rangier-/Durchverbindungsorte im Hauptverteiler, Zwischenverteiler und Bereichsverteiler, wie in Bild 13 dargestellt, verwendet werden; …“ (siehe Abbildung 5).

Abbildung 5: Handhaben von Umzügen (Bild 13 der Norm)

Nur der Hauptverteiler wird in der Norm als notwendiger Verteiler gesehen, alle anderen, also auch der Bereichs- und Zwischenverteiler, sind optional. Somit wäre im Sinne der Norm jeder Hauptverteiler mit einem zentralen Rangierort (ZRO) auszustatten, und jedes Rechenzentrum ab VK2 würde einen solchen besitzen. Dem Autor sind mehrere Planungen von neuen Rechenzentren bekannt, bei denen ein ZRO nicht vorgesehen wird, ob das einer Ablehnung einer beantragten Zertifizierung im Wege stehen wird, ist nicht bekannt.

Bei der weiteren Betrachtung konzentrieren wir uns auf den zentralen Rangierort und werden daran die Vorteile und Nutzungsmöglichkeiten beleuchten, entsprechend lassen sich diese dann auch auf den Bereichsrangierort übertragen.

Nutzen des BRO oder ZRO

Es muss kritisch hinterfragt werden, ob die normativ „erzwungene Notwendigkeit“ tatsächlich so sinnvoll ist. Bei jedem Einsatz von BRO und ZRO muss unbedingt folgender Nachteil berücksichtigt werden:

Glasfaserverbindungen: Jede Durchrangierung kostet Dämpfung, die sehr schnell zu einer Überschreitung des Channel Insertion Loss führen kann und insbesondere bei Multimode eher zu vermeiden ist (Singlemode hat ein größeres Dämpfungsbudget und macht das einfacher).

Twisted Pair: Durchrangierungen sind grundsätzlich machbar, doch sehr ungewöhnlich. Bei geplantem Einsatz von 25 Gbit/s oder 40 Gbit/s ist die zulässige Anzahl von Verbindungen auf 2 beschränkt, eine Durchrangierung wäre also nicht möglich.

Was wäre der Nachteil, wenn es keinen BRO oder ZRO gäbe? Das hängt vom Netzwerk-Design ab:

Möglichkeit 1: Die Switches werden nicht zentral positioniert, sondern befinden sich in den Serverracks (ToR) oder in einzelnen Netzwerk-Racks innerhalb der Schrankreihen (EoR oder MoR), nach Norm wäre dies dann der Bereichsverteiler. Beim ToR ist ein BRO nicht sinnvoll. Beim MoR/EoR-Ansatz würde man im Serverrack Rangierfelder platzieren (das entspricht dann den Geräteanschlüssen GA), auf die die Server aufgeschaltet werden und dann im Netzwerk-Rack direkt „runter zu den Switches“ patchen. Eine zusätzliche Möglichkeit zur Durchrangierung ergibt – wenn überhaupt – nur bei sehr langen Schrankreihen Sinn. Im allerbesten Fall wäre der ZRO für LWL-Verbindungen zu Switches denkbar, die sich nicht in der Reihe befinden oder für Backbone-Verbindungen, die in der Regel nur in einer sehr überschaubaren Anzahl vorkommen.

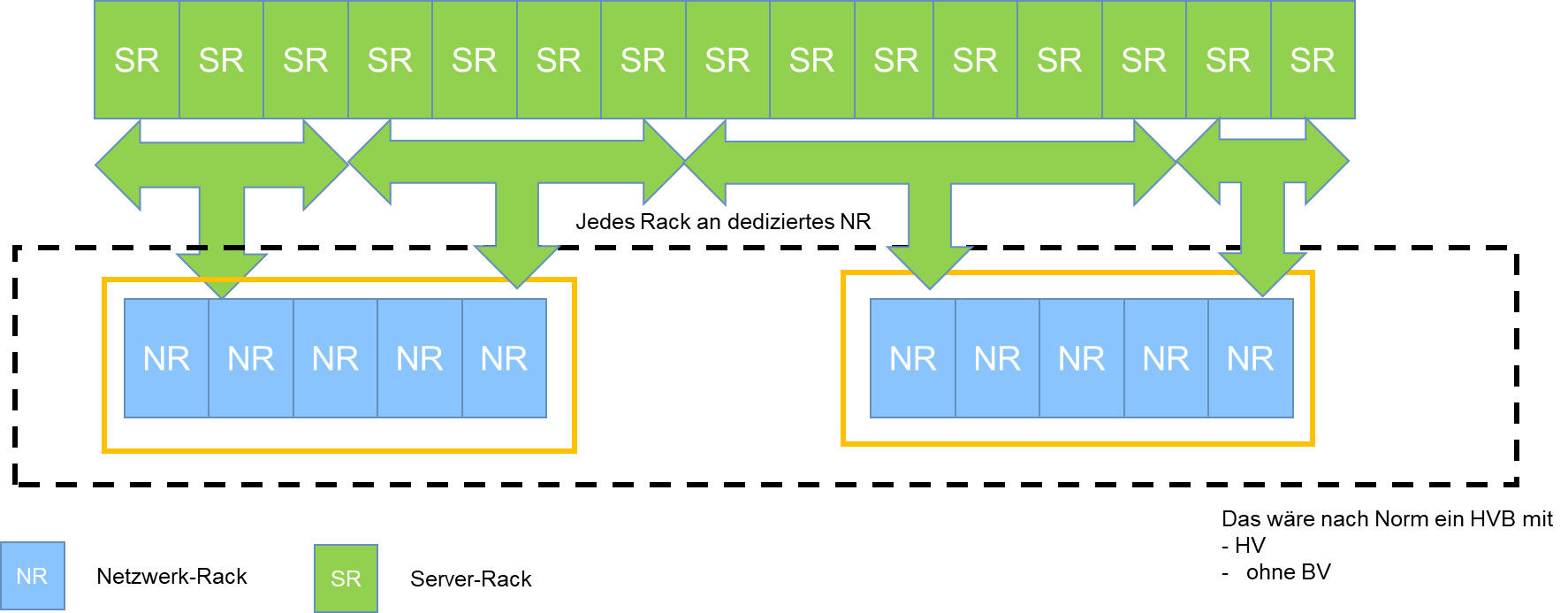

Möglichkeit 2: Es gibt keinen „eigenen“ Bereichsverteiler, stattdessen befinden sich die Switches zentral im Hauptverteilungsbereich, und von dort aus gibt es Verbindungen zu den Serverracks (siehe Abbildung 6). Unter Betrachtung der Dämpfungsanforderungen wäre das optimal. Stellt man sich jedoch ein sehr komplexes Rechenzentrum mit mehreren Netzwerk-Racks und dutzenden Serverracks vor, so würde es zu einer sehr unübersichtlichen Verkabelungstopologie kommen. Jedes Serverrack müsste direkt mit jedem Netzwerk-Rack verbunden werden, in dem sich die zugehörenden Access-Switches (Leaf-Switches) befinden. Betrachtet man das Netzwerk-Rack mit den Rangierfeldern als Sternmittelpunkt der Verkabelungstopologie, so würde es im Rechenzentrum sehr viele Sternmittelpunkte geben. Würde ein solches Netzwerk-Rack entfernt, so müssten alle abgehenden Kabel umverlegt oder gar neu verlegt werden. Würde ein Serverrack ergänzt, müssten viele neue Kabel zu verteilt stehenden Netzwerk-Racks gezogen werden. Genau diese Inflexibilität sieht die Norm und geht davon aus, dass ab der Verfügbarkeitsklasse 2 der Rangierort Vorteile bringt (siehe Abbildung 6).

Abbildung 6: Schemadarstellung der Anwendung ohne ZRO (VK2)

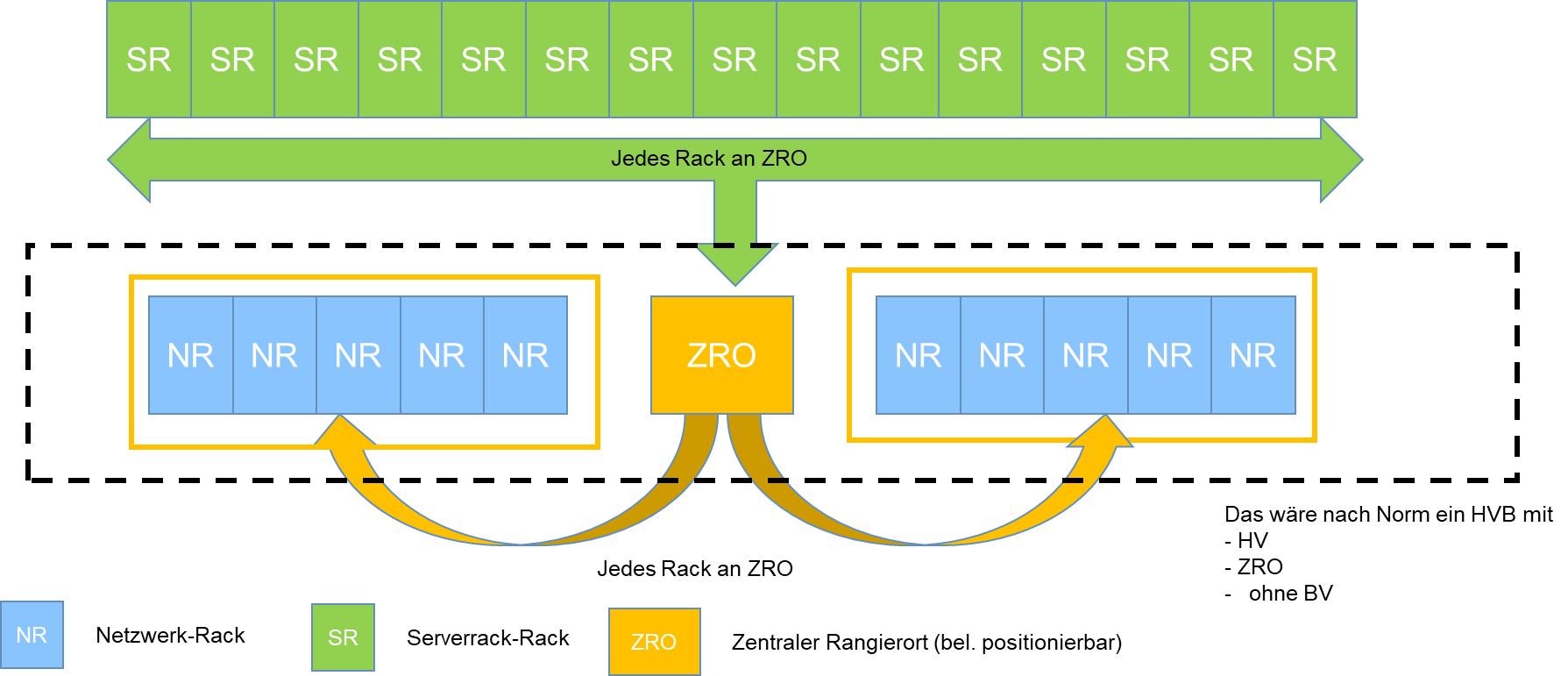

Und tatsächlich, mit dem Einsatz eines ZRO bildet der ZRO den einen einzigen Sternmittelpunkt. Alle Serverracks und alle Netzwerk-Racks werden immer an diesen angeschlossen (siehe Abbildung 7 für die Planung eines ZRO-Serverraums). Sowohl auf der Seite der Netzwerk-Racks als auch in Serverracks lassen sich Änderungen durchführen, die nicht zu einer Beeinträchtigung der grundsätzlichen Verkabelungsarchitektur führen.

Beispiel 1: Wird festgestellt, dass ein bestimmtes Serverrack (SR) eine höhere Anzahl an Multimodefasern benötigt, so muss lediglich die Faseranzahl zwischen SR und ZRO erhöht werden (= nachverkabeln); vorausgesetzt, bei der Planung wurde eine ausreichende Reserve zwischen Netzwerk-Rack (NR) und ZRO vorgesehen.

Beispiel 2: Aus Kapazitätsgründen müsste ein weiteres NR ergänzt werden, dieses soll allerdings mehrere Serverracks versorgen. Es reicht dann je nach Kapazität aus, nur die Verkabelung vom neuen NR an den ZRO zu ergänzen, eine Nachverkabelung zu jedem SR ist nicht zwingend notwendig (siehe Abbildung 7).

Ab VK3 ist im Serverraum grundsätzlich eine redundante Topologie aufzubauen, sodass eine einfache sternförmige Anbindung der Serverracks nicht ausreichen würde. Bei VK2 und VK3 reicht die Verdopplung der Kabel, und bei VK4 wird ein zweiter ZRO gefordert. Damit wird auch diese Struktur deutlich übersichtlicher, als wenn man dutzende Einzelanbindungen der Serverracks an verteilt stehende Netzwerk-Racks planen würde.

Wie wir gesehen haben, sieht die Norm den ZRO bei häufigen Veränderungen im Serverraum als Vorteil an. Würde man von einem statischen Aufbau bzw. einer erwarteten statischen Verkabelung ausgehen, so wäre der Vorteil des ZRO hinfällig. Das ist möglicherweise der Grund, warum bei vielen RZ-Planungen auf den ZRO verzichtet wird.

Abbildung 7: Schemadarstellung der Anwendung von ZRO (VK2)

Anforderungen an ZRO

Die Norm selber ist sehr zurückhaltend bei der Beschreibung von Anf

orderungen oder gar mit Darstellungen, wie ein ZRO aufzubauen ist. Sie beschränkt sich lediglich auf:

- Die Gestelle müssen an der Rückseite eine ausreichende Zugänglichkeit zur Kabeleinführung von ein- und ausgehenden Kabeln sowie an der Seite zur Rangierschnurführung haben.

- Die Auslegung und Auswahl muss die maximal geplante Verkabelungskapazität und Verkabelungsdichte berücksichtigen.

Punkt 1 macht jedoch bereits deutlich, wie man sich das „Rangieren“ vorstellt: Die Führung der Rangierkabel soll an der Seite erfolgen. Klassische Installationen benutzen in den Racks die Seite nur zur senkrechten Führung der Patchkabel, die horizontale Führung erfolgt entweder direkt nach links oder rechts „abgehend“ vom Rangierfeld oder nach unten/oben zu einer 19“-Kabelführung (siehe Abbildung 8).

Abbildung 8: Beispiel für Führung von Anschlussschnüren

Der ZRO wird in erster Linie nicht zur Komprimierung von Datenanschlüssen auf Rangierfeldern verwendet, wie man oftmals in Produktunterlagen darzustellen versucht, sondern er soll neben der beschriebenen Vereinfachung der Änderungen von Festverkabelung

insbesondere das Durchrangieren erleichtern.

Technische Lösungen

Grundsätzlich ist es natürlich möglich, jedes 19“-Rack per Definition als ZRO oder BRO einzurichten. In diesem Fall würden die Stromversorgung und die Kühlung entfallen. Man würde hochverdichtende oder auch normale Rangierfelder einbauen und mit der Festverkabelung verbinden. Es wird einen Bereich mit „eingehenden“ und „ausgehenden“ Kabeln geben, beispielsweise definiert man die von den Serverracks kommenden als eingehende und die zu den Netzwerk-Racks verlegten als ausgehende Kabel. Befinden sich beide Bereiche im selben Rack mit klassischer Horizontal– und Vertikal-Patchkabelführung, so wird bei einer extrem hohen Packungsdichte sehr schnell ein Bedienbarkeitsproblem entstehen. Entweder

- operiert man mit passgenauen Patchkabellängen, dann reduziert sich das Problem der hinderlichen Überlängen, dafür muss bei Umpatchungen mit Austausch gegen passende Kabel gerechnet werden, was je nach Patchgrad ein sehr mühsames und fehleranfälliges Unternehmen ist, oder

- man nimmt Standardlängen bei den Patchkabeln, die zwar eine Durchrangierung zwischen jedem Punkt des Racks möglich machen, doch das Problem der Überlängen mit sich bringen und zu der Frage führen „wohin mit den Schlaufen?“.

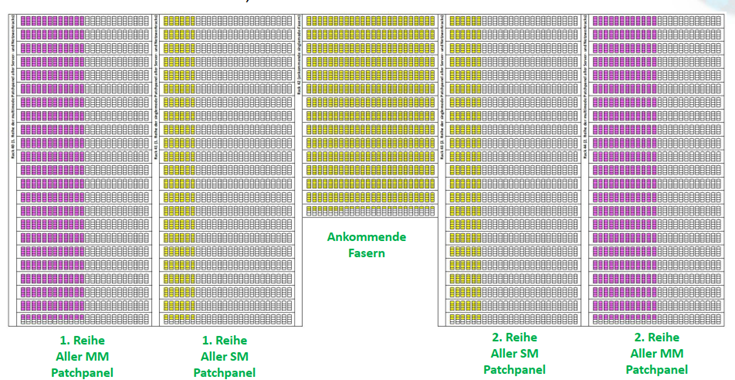

Sowohl bei dem Bedarf nach mehr als einem Rack zur Unterbringung der Rangierfelder als auch dem nach Aufteilung der Kabel in Racks mit ankommenden und abgehenden Kabeln könnte es also sinnvoll sein, mind. 2 Racks vorzusehen. Die oben beschriebenen Probleme bei der Patchung bleiben bzw. verschärfen sich. Wenn noch mehr Racks für den ZRO benötigt werden, ist die Querverschaltung beinahe unmöglich, wie nachfolgend ein Beispiel für eine Rackanordnung zeigt Abbildung 9.

Man stelle sich bei Abbildung 9 vor, dass eine Patchung von einem Stecker ganz links unten nach ganz rechts oben verändert oder entfernt werden soll. Dies wäre extrem aufwendig und mit dem Risiko von Beschädigungen anderer Patchungen verbunden.

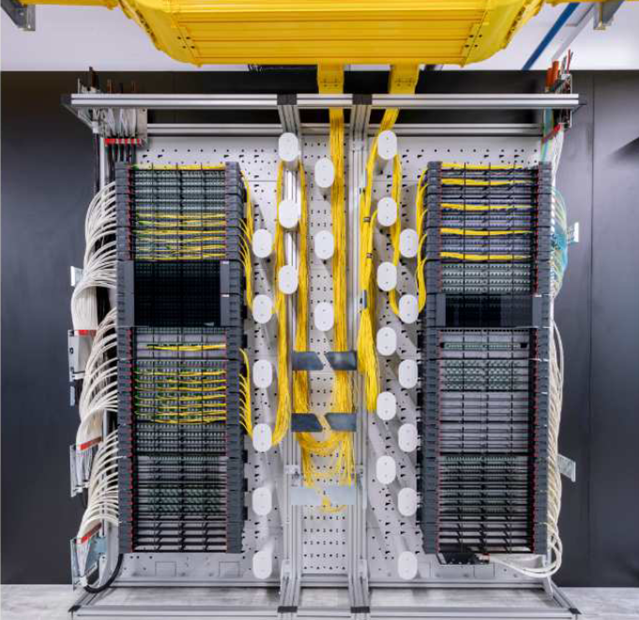

Ein anderer Lösungsweg hat seine Wurzeln bei der Glasfasertechnik im Providerumfeld. Hier ist typischerweise sehr oft mit Knotenpunkten zu rechnen, bei denen extrem viele Fasern – zumeist Singlemode – ankommen und weggehen und dort einfach nur durchgeschaltet werden. Da aktive Technik nicht in diese Punkte eingesetzt wird, verzichtet man auf Racks, die einen solchen Einbau möglich machen, und versucht viel mehr, mit platzsparenden Gestellen eine hohe Packungsdichte zu erzielen. Hier sind Gestelleinheiten mit einer Tiefe von 30 cm typisch.

Das nachfolgende Produktbeispiel (Abbildung 10) von RdM soll das Grundprinzip der ODF-Technologie (ODF = Optical Distribution Frames) zeigen.

Abbildung 9: Großer ZRO auf Basis von 19“-Technik

Es ist eine Technik erkennbar, bei der ein Verteilergestell (z. B. das linke) die ankommenden Fasern aufnimmt und ein anderes die abgehenden. Die passive Durchrangierung erfolgt also horizontal von links nach rechts. Dazu werden die Patchkabel auf die LWL-Kupplungen wie üblich aufgesteckt, und dann wird das Patchkabel mithilfe von in der Mitte befindlichen Spulen so geführt, dass die Überlänge des Kabels durch die Führung kompensiert wird. Somit müssen keine Überlängenschlaufen aufgewickelt oder „versteckt“ werden. Am Rangierfeld selber werden die Patchkabel nur in eine Richtung weggeführt, und zwar direkt von der Steckerverbindungsstelle nach links oder rechts, also kein „Scheitelprinzip“ mit zusätzlichen 19“-Kabelführungen. Grundsätzlich kann man mit einer einzigen Patchkabellänge eine Verbindung zwischen beliebigen LWL-Steckern schalten. Eine Farbkennzeichnung der Spulen oder ein einfaches Schema ermöglicht es dem Betriebspersonal, dieses zu tun, ohne großartige Berechnungen o.Ä. durchführen zu müssen, wie genau man das Patchkabel führt. Einige Hersteller bieten dazu Guides an, u.a. auf Softwarebasis (siehe Abbildung 11).

Damit das Wegführen der Patchkabel von hochverdichtenden Rangierfeldern – gilt auch bei Nicht-Einsatz von ODF – überhaupt funktionieren kann, sind besondere Patchkabel mit besonderen Techniken zu benutzen:

- Sogenannte „Uni-Boot-Kabel“ mit extrem dünnem Kabelaußendurchmesser (das Gegenstück zu Zip-Cord).

- Sogenannte „Push-Pull-Technik“ am Stecker, bei dem der Stecker ohne Drücken eines Entriegelungshebels gezogen werden kann.

Für den Fall, dass die Anzahl der Fasern keine zwei Gestelleinheiten benötigt, kann auch alles in einer Einheit erfolgen, die Technik der Patchkabelführung mit den Spulen bleibt gleich (siehe Abbildung 12).

Abbildung 10: ODF-Technik von RdM

Der ODF lässt sowohl den Abschluss von vorkonfektionierten Trunk-Kabeln wie auch den von klassischen Installationskabeln zu, die gespleißt werden müssen. Es ändert sich dann die Rangierfeldeinheit, die die LWL-Kabel aufnimmt.

Wie bereits beschrieben ist ein ZRO mit Twisted-Pair grundsätzlich auch denkbar, und die Norm sagt nichts Gegenteiliges. Doch fehlen dazu – anders als bei ODF-Lösungen – die Angebote der Hersteller. Diese konzentrieren sich auf das Medium Lichtwellenleiter.

Produktauswahl

Die Anzahl der verfügbaren Produkte von ZRO mit einer ODF-Technik ist sehr beschränkt, und die Produkte unterscheiden sich in Details. Je nach Detail und seiner Bewertung kann eine Lösung allerdings besser oder schlechter in das jeweilige Rechenzentrum passen.

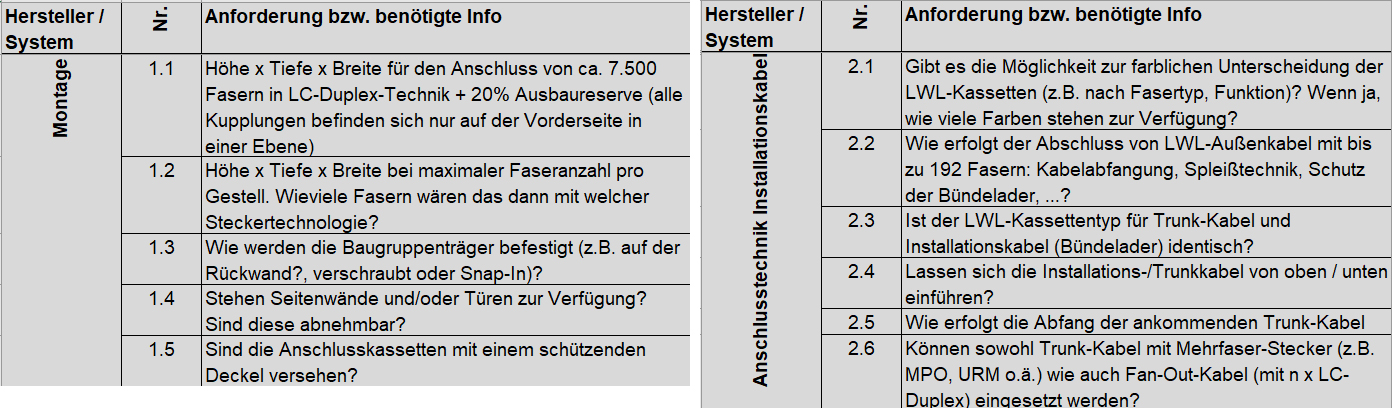

Im Rahmen eines konkreten Projektes wurde ein Anforderungskatalog erstellt, den man den Systemanbietern zur Verfügung gestellt hat und auf dessen Basis dann entschieden wurde, wie mit den Unterschieden umzugehen ist. Im Katalog wurden 3 Hauptgruppen gebildet:

- Anforderungen an die Montage der Gestelleinheit

- Anforderungen an die Anschlusstechnik der Installationskabel

- Anforderungen an die Rangiertechnik

Zu zwei Gruppen nachfolgend ein paar Beispiele der definierten Anforderungen (Abbildung 13).

Abbildung 11: Seitliche Patchkabelführung am Rangierfeld (RdM)

Die unten aufgeführten Produkte () sind Beispiele und beinhalten keinen Anspruch auf Vollständigkeit der am Markt verfügbaren Systeme. Allen gemeinsam ist

- die geringe Tiefe der Gestelleinheiten,

- die Möglichkeit zur freien Montage der Gestelleinheiten im Raum mithilfe von Deckenstielkonstruktionen,

- die Fähigkeit, mehrere Tausend Fasern anzuschließen (die Begrenzung entsteht in erster Linie durch die Packungsdichte des Steckverbinders am Rangierfeld),

- die beschriebene Spulentechnik,

- die Möglichkeit sowohl RZ-typische Trunk-Kabel wie auch klassische Installationskabel mit Spleißtechnik anzuschließen,

- das Herausziehen der Rangierfelder (in der Regel in einer Schubladentechnik ausgeführt)aus dem Aufnahmegehäuse führt zu keinem Stressen der Fasern der installierten Kabel und der Patchkabel, auch die Einhaltung der Biegeradien wird garantiert,

- ein Sockel-Bereich unterhalb der Montage- und Rangierebene, in dem auch ein gestellübergreifendes Patchen möglich wird,

- die Wahlmöglichkeit bei den vorkonfektionierten Kabeln zwischen Trunk-Kabel mit MPO oder Trunk-Kabel als Fan-Out (= Standard-Local-Connector- oder anderer Stecker bildet den Abschluss),

Abbildung 12: ODF-Technik von Corning

- die Möglichkeit zur Verwendung von anderen Anschlusstechniken im Front-Access-Bereich statt Local Connector (LC),

- dieselbe Rangierfeldtechnik kann grundsätzlich – bei den meisten Systemen – auch außerhalb des ZRO, z. B. im Serverrack oder Netzwerk-Rack, verwendet werden.

Unterschiede gibt es bei der technischen Lösung hinsichtlich der Zuführung von installierten Kabeln und insbesondere der Wegführung der Patchkabel. Dazu nachfolgend ein paar Beispiele.

ODF-Lösung FACT von Commscope

Bei Commscope stehen die Kupplungen zur Seite ausgerichtet, d.h. in den Rangierbereich zeigend, sodass die Patchkabel nicht erst abgewinkelt zur Seite geführt werden müssen. Die Steckverbindungen befinden sich prinzipiell somit in einem besser geschützten Bereich. Dafür steht der Begriff „Side-Access“ (siehe auch Abbildung 14). In der Regel müssen bei Side-Access-Systemen die Rangierfelder etwas herausgezogen werden, um Zugang zur Kupplung zu bekommen.

ODF-Lösung Edge von Corning

Bei Corning stehen, wie bei den meisten ODF-Lösungen, die Kupplungen nach vorne, also eine durchaus bekannte Variante, auch „Front-Access“ genannt, welche die überwiegende Mehrheit aller Rangierfeldlösungen innerhalb und außerhalb des RZs bevorzugt. Der Komfortunterschied zwischen Side-Access und Front-Access kann nur subjektiv bewertet werden. Es wird empfohlen, sich die Demo-Installationen anzusehen und selber zu patchen.

ODF-Lösung LISA von Huber & Suhner

Es werden sowohl Side-Access- als auch Front-Access-Systeme angeboten (systemabhängig) (Abbildung 14).

ODF-Lösung ODF-Prime von Reichle de Masari

Es werden Front-Access-Systeme angeboten.

Abbildung 13: Auszüge aus Anforderungskatalog

Fazit

Es stellt sich wie immer bei den technischen Lösungen der geplanten IT-Verkabelung in einem Rechenzentrum die Frage, wie „normkonform“ man diese Verkabelung machen möchte. Die Norm spricht eine klare Empfehlung aus, ab wann ein Rangierort ein Element der Verkabelung sein soll. Die Vorteile wurden oben an einfachen Beispielen gezeigt und wirken erst bei häufigen Änderungen der Verkabelungen im Serverraum. Ist weder diese Flexibilität noch die Norm-Konformität gefordert, sosteht es dem Nutzer frei, auf einen ZRO oder BRO zu verzichten, denn beide bringen auch Nachteile mit sich, die zu bewerten sind.

Vereinfacht gesagt tauscht man bei Einsatz eines ZRO die bessere Bedienbarkeit gegen etwas schlechtere Übertragungseigenschaften der Strecken und Mehrkosten ein. Entscheidet man sich für einen ZRO, so ist eigentlich nur eine ODF-basierende Lösung sinnvoll, und dazu stehen verschiedene Produkte zur Verfügung.

Abkürzungen

Abbildung 14: Das Innere einer Rangierfeldeinheit mit Side-Access (Huber & Suhner)

EN Europäische Norm

MoR Middel-of-Row

EoR End-of-Row

ToR Top-of-Rack

ÜR Übergaberaum

ENS Externe Netzschnittstelle

HVB Hauptverteilungsbereich

ZVB Zwischenverteilungsbereich

BVB Bereichsverteilungsbereich

GVB Geräteverteilungsbereich

ZRO Zentrale Rangierort

BRO Bereichsrangierort

VK Verfügbarkeitsklasse

ODF Optical Distribution Frames