aus dem Netzwerk Insider Mai 2022

Wer die Öffentlichkeitsarbeit großer Hersteller aus dem Umfeld der Kommunikations-IT in den letzten Jahren verfolgt hat, dem wird aufgefallen sein, welchen Stellenwert das Thema Künstliche Intelligenz (KI) dort einnimmt: Egal ob in Blogs, Videos, Newslettern oder Veranstaltungen – das Thema war und ist geradezu allgegenwärtig. Und das mittlerweile schon seit einigen Jahren. Grund genug, um noch einmal einen Blick auf das Feld zu werfen und zu bewerten, was hinter diesem hartnäckigen Hype steckt, wieviel davon gerechtfertigt ist und worauf man in Zukunft hoffen darf.

Was ist eigentlich Künstliche Intelligenz?

Eines vorweg: Niemand sollte damit rechnen, dass wir kurz vor dem Durchbruch für eine künstliche Superintelligenz à la HAL 9000, Skynet etc. stehen. Selbst wenn in der Werbung teilweise mit solchen (dann allerdings positiven) Ausblicken kokettiert wird, reden wir hier ausschließlich von sogenannter „schwacher“ Künstlicher Intelligenz. Dahinter verbergen sich Methoden, welche nur für die Bearbeitung spezieller Aufgabenstellungen gedacht sind und kein tatsächliches intelligentes Bewusstsein schaffen sollen, wie das bei einer „starken“ Künstlichen Intelligenz der Fall wäre.

Darüber hinaus wird es knifflig, was die Definitionen zur Künstlichen Intelligenz betreffen: Während wir im Bereich der natürlichen Intelligenz zumindest einen groben Konsens zur Definition oder zumindest zu dem Nachweis der Intelligenz von Individuen haben, wird es bei der Künstlichen Intelligenz deutlich schwieriger.

Eine echte Bestimmung des Begriffs hatten wir noch nie, und dass das Thema in den letzten Jahren durch Werbung und medialen Hype wieder und wieder aufgegriffen wurde, hat die Sache nicht besser gemacht. Inzwischen beobachte ich immer wieder, dass maschinelle Entscheidungen, die durch einfache Wenn-Dann-Beziehungen (if-then-else) getroffen werden können, als Künstliche Intelligenz verkauft werden. Da fragt man sich natürlich, was demnach nicht mehr intelligent ist. Schließlich geht es um Aufmerksamkeit, und da lässt sich ein unklar definierter Hype-Begriff immer gut verwenden.

Tatsächlich ist der Begriff, oder vielmehr das Forschungsfeld dahinter, alles andere als neu. Gegründet wurde das akademische Fachgebiet der Künstlichen Intelligenz im Jahr 1956 auf der Dartmouth-Konferenz. Damals ging man noch davon aus, dass man die Intelligenz eines Menschen in weniger als einer Generation erreichen konnte. Man glaubte also, innerhalb relativ kurzer Zeit sogar eine starke KI entwickeln zu können.

Im folgenden Jahr prognostizierte man, dass es innerhalb der nächsten zehn Jahre ein auf Künstlicher Intelligenz basierenden Schachweltmeister geben würde. Inzwischen wissen wir, dass beide Prognosen viel zu optimistisch waren.

Der Hintergrund ist ein grundlegendes Problem der Künstlichen Intelligenz: Die zu lösenden Probleme sind sehr komplex und skalieren sehr ungünstig. So können zwar vielversprechende Ansätze gefunden werden, die kleine Beispielprobleme lösen können. Sobald diese Problemstellungen jedoch ausgeweitet werden, steigt die Komplexität enorm an, sodass die notwendigen Rechen- bzw. Speicherressourcen und somit auch die benötigten Zeiten schlagartig durch die Decke gehen. Reale Probleme bleiben damit häufig unlösbar, und die Ansätze sind nicht allgemeingültig.

Man könnte also sagen, die Geschichte der KI sei eine Folge von großen Erwartungen und noch größeren Enttäuschungen, denn sie handelt von einem Zyklus neuer Ansätze, welche aufgrund der Komplexität der realen Probleme doch wieder im Sand verlaufen. Auf neue Ansätze folgten zuweilen Jahre der Ernüchterung, in denen das Feld der Künstlichen Intelligenz wenig angesagt war, bevor es mit einem neuen Ansatz wieder von vorne losging.

Dementsprechend liegt die Vermutung nahe, dass es sich dieses Mal ebenfalls nur um eine weitere Iteration des ewigen Zyklus handelt. Und darin liegt sicherlich ein gehöriges Stück Wahrheit. Nichtsdestotrotz wäre es zu kurz gegriffen, das Thema damit einfach abzuhaken, denn es gibt durchaus einige Argumente, die dafürsprechen, etwas genauer hinzusehen.

Es steckt mehr als nur Hype hinter dem Thema

Zunächst einmal muss festgehalten werden, dass neben den Enttäuschungen der Vergangenheit durchaus auch bedeutende Erfolge erzielt werden konnten. Allerdings werden diese vielfach nicht dem Feld der Künstlichen Intelligenz zugeschrieben. Interessanterweise liegt dies häufig an der bereits thematisierten fehlenden Definition des Begriffs, wodurch Themengebiete, die ehemals zum Forschungsgebiet der Künstlichen Intelligenz gezählt wurden, in der Folge nicht mehr darunterfielen. Dies gilt beispielsweise für Anwendungen im Compilerbau oder in der Regelungstechnik. Heute hingegen wird gern das Gegenteil getan, wenn simple Anwendungen als „intelligent“ angepriesen werden.

Ebenso gibt es im aktuellen KI-Hype viele Anwendungen, die nicht nur beeindruckende, sondern auch in der realen Welt nutzbare Ergebnisse liefern, von denen ich nachfolgend noch einige nennen möchte. An dieser Stelle sei exemplarisch lediglich eine Anwendung genannt: Autonomes Fahren. Seit vielen Jahren gibt es diverse Prototypen autonom fahrender Autos, die teilweise bereits viele tausend Kilometer im realen Straßenverkehr vollständig autonom gefahren sind. Als Beispiel sei hier nur das „Self-driving car“ von Google bzw. der Alphabet-Tochter Waymo genannt, die unter dem Label Waymo One als Roboter-Taxi in Phoenix fährt.

Natürlich müssen hier noch schwierige technologische, juristische und sogar ethische Fragen beantwortet werden. Doch braucht es auf der anderen Seite nicht allzu viel Phantasie, um sich das disruptive Potenzial einer solchen Technologie sowie die Konsequenzen auszumalen, die sich daraus für das gesamte Verkehrswesen und der zugehörigen Wirtschaftszweige ergeben können.

Die Frage ist dabei längst nicht mehr ob, sondern wann wir eine solche Technologie erleben werden. Dementsprechend groß sind das Interesse und die Investitionen auch aus der Wirtschaft. Darum haben wir schon lange aufgehört, nur von grauer Forschung zu sprechen, denn schließlich geht es um konkrete Anwendungen. Letztendlich haben wir inzwischen auch unseren künstlichen Schachweltmeister bekommen. Zwar hat es dann noch satte 40 statt der zunächst erwarteten zehn Jahre gedauert, doch 1997 war es mit Deep Blue dann endlich soweit.

Nicht zuletzt werden die Randbedingungen für KI-Anwendungen fortlaufend besser. Entscheidend ist dabei eher weniger die stetige Steigerung der Rechenleistung moderner Computersysteme (da KI-Probleme schlecht skalieren), sondern vielmehr die Fortschritte in benachbarten Feldern, zum Beispiel im Bereich der Bereitstellung von Daten. Hier kommen andere Hype-Themen wie IoT oder Sensorfusion zum Tragen, da sie wertvollen Input für so manchen KI-Ansatz liefern können.

Grundlage des aktuellen Zyklus

Der aktuelle Zyklus begann mit dem Ansatz des sogenannten Deep Learning, der in den Medien ebenfalls gern genannt wird, weil er schön griffig ist und die Phantasie anregt. Dabei handelt es sich um eine spezielle Ausprägung des Maschinellen Lernens, die wiederum auf dem erweiterten Ansatz der Neuronalen Netze basiert, den es bereits seit den 60er oder teilweise sogar 40er Jahren gibt. Er fußt auf einem Modell des menschlichen Gehirns bzw. der Neuronen, aus denen das Gehirn besteht. Deep Learning erweitert diesen Ansatz um einige technische Ansätze, die die praktische Anwendbarkeit dieser Technologie vergrößern und zu neuen Anwendungen, insbesondere in dem Bereich der Sprach- und Bildverarbeitung geführt haben. Trotz des Namens und der Inspiration durch ein (mittlerweile veraltetes) Modell echter Neuronen handelt es sich um einen reinen technischen Ansatz, welcher niemals zu einem künstlichen Gehirn, sprich starker KI, skalieren wird. Die Nachbildung des menschlichen Gehirns wird derweil durch einen vollkommen anderen Ansatz im „Human Brain Project“ verfolgt.

Die Netze der künstlichen Neuronen müssen mit realen Beispieldaten „trainiert“ werden. Bei diesem Prozess spielt der Zufall eine wichtige Rolle, denn gleich an mehreren Stellen wird ganz bewusst mit Zufallszahlen gearbeitet. Dementsprechend ist das Ergebnis eines solchen Trainings nicht deterministisch, d.h. wenn es mehrmals durchlaufen wird, kommen jeweils unterschiedliche Ergebnisse dabei heraus. Das ist einer der Gründe, weswegen mein Professor seinerzeit skeptisch gegenüber diesen Ansätzen war, da die Entwicklung solcher Systeme in Teilen einem Glücksspiel gleicht und das Ergebnis nicht vollständig nachvollzogen oder gar nach Fehlern untersucht werden kann. Niemand kann letztlich sagen, warum genau das System eine konkrete Entscheidung getroffen hat. Das kann bei fatalen Fehlentscheidungen (zum Beispiel beim Autonomen Fahren) durchaus problematisch sein.

Gleichzeitig bedarf es neben technischen Grundlagen auch einer gewissen Menge Erfahrung und Fingerspitzengefühl (und nicht zuletzt Glück), um die Trainingsdaten und Algorithmen derart aufzubereiten, dass für einen konkreten Anwendungsfall ein brauchbares Ergebnis herauskommt.

Inzwischen haben sich Ansätze etabliert, bei denen der Prozess des Anlernens von mehreren KI-Systemen durchgeführt wird. Dabei erzeugt ein KI-System Ergebnisse (zum Beispiel Bilder von Katzen), und das andere KI-System bewertet die Ergebnisse (Ist das ein Bild einer Katze?).

So können deutlich mehr Daten verarbeitet werden, und das Erzeugersystem erhält eine umfassende Trainingsbasis, ohne dass das Training mühselig durch Menschen überwacht werden muss. Sogenannte Generative Adversarial Networks (GAN) verfolgen genau diese Idee und sind Grundlage etlicher Systeme, die Inhalte wie zum Beispiel Bilder, Videos oder Text erzeugen sollen.

Viele Anwendungen dieser Technologien liegen im Bereich der Kommunikation und sollen die modernen Enterprise-Lösungen aufwerten. Dort können sie durchaus Sinn ergeben, denn es werden insbesondere Sprache, Ton, Bild und jede Menge weitere Daten verarbeitet. Wenn man sich jedoch die aktuellen Enterprise-Lösungen anschaut, dann hält sich die Begeisterung bei den Anwendern oft noch in Grenzen.

Grund dafür sind die hohen Ansprüche, die an Lösungen aus dem Enterprise-Segment gestellt werden. Hier liegt der Fokus traditionell auf Zuverlässigkeit, Robustheit und Sicherheit. All das sind Themen, die bei diesen jungen Technologien erst nach und nach berücksichtigt werden. Zwar steigt durch den Aufstieg von Lösungen aus der Cloud und den damit verbundenen agilen Softwarebereitstellungsarten auch hier die Bereitstellungsgeschwindigkeit und sogar in gewissem Maß die Experimentierfreude, jedoch sehen wir noch einen deutlichen Unterschied zu Lösungen aus dem Consumer-Umfeld.

Dort sind es vor allem Firmen wie Google, die fortlaufend neue KI-Anwendungen herausbringen, um sie von der willigen Anwenderschaft testen zu lassen. Was sich nicht bewährt, wird ebenso schnell wieder abgestoßen. Daneben etablieren sich allerdingsauch KI-Anwendungen, wie beispielsweise Google Translate oder Google Lens.

Wenn man ein wenig weiter in die Zukunft dieser Lösungen schauen möchte, dann kann man sich Veröffentlichungen aus der Forschung ansehen. Hier fehlt meist noch einiger Schliff für die Anwendung in der breiten Praxis, doch dafür sind manche der Ergebnisse deutlich beeindruckender.

Im Folgenden möchte ich einige Ansätze vorstellen, die sich aktuell in Forschung und Entwicklung befinden, doch zunehmend den Weg in praktische Enterprise-Lösungen finden. Dabei wird zunächst grob nach Anwendungsbereichen sortiert (Audio/Video), bevor es an die „intelligenten“ Systeme geht, bei denen Ansätze kombiniert werden.

Sprachverarbeitung

In der Sprachverarbeitung gibt es generell eine Menge für KI-Systeme zu tun. Vieles davon kennen wir bereits seit vielen Jahren in diversen Anwendungen, allerdings zum Teil in fragwürdiger Qualität. Dass diese unausgereiften Systeme dann doch den Weg in die Praxis gefunden haben, zeugt von dem Bedarf. Die einfacheren Systeme synthetisieren Sprache aus Text (Text to Speech). Das können simple Audio-Meldungen sein bis hin zum Vorlesen unbekannter Nachrichten, wie man das u.a. bei empfangenen Kurznachrichten im Auto erleben kann. Hier ist die Qualität der Sprache mitunter durchaus beeindruckend und weit weg von den sehr künstlichen Roboterstimmen der Vergangenheit, wie man sie beispielsweise von Stephen Hawkings Sprachsynthesizer kannte, den er bis zu seinem Tod nutzte, obwohl es Upgrades gegeben hätte.

Neuere Systeme sprechen nicht nur die einzelnen Wörter überzeugend aus, sondern intonieren ganze Sätze, versehen sie mit „Emotion“ sowie künstlichen Pausen und Versprechern, wodurch sie kaum noch von menschlichen Sprechern zu unterscheiden sind. Dazu gibt es sehr beeindruckende Demos von Google oder von NVIDIA, die vor einigen Monaten ihr neues RAD-TTS System zur Sprachsynthese vorgestellt haben.

Was vielen nicht bewusst ist: Synthetisierte Sprache kann auch echte Stimmen nachbilden. Die Frage hierbei ist nicht mehr, ob es funktioniert, sondern lediglich wieviel Material einer Originalstimme benötigt wird, um diese überzeugend zu imitieren. Dabei geht es nur um Sekunden. Dazu gab es bereits 2018 eine Veröffentlichung mit vielen Beispielen, bei der nur fünf Sekunden einer Stimme genutzt wurden, um eine Reihe von Standardsätzen in dieser Stimme zu synthetisieren („Transfer Learning from Speaker Verification to Multispeaker Text-To-Speech Synthesis“).

Durch diese Methoden ergeben sich neben den sinnvollen Anwendungen natürlich auch für Betrüger vollkommen neue Möglichkeiten. Im Bereich des Voice Phishing (oder Vishing) können sehr gezielte Attacken durchgeführt werden. Die mäßige Qualität in den öffentlichen Telefonnetzen wirkt da sogar noch unterstützend.

Zweifelsohne funktioniert es auch in umgekehrter Richtung: Verarbeitung von gesprochener Sprache bzw. Speech to Text. Hier gibt es viele praktische Helferanwendungen, die wir in unserem Alltag nutzen können. Es fängt mit einer einfachen Menüführung per Sprachbefehl an. Als erweitertes Beispiel sei die Transkription von Meetings genannt. Dieses Feature wird inzwischen von vielen Meeting-Lösungen aus der Cloud geboten, u.a. bei Cisco Webex, Microsoft Teams oder Zoom.

Dabei wird das gesprochene Wort entweder in Echtzeit oder in einem Nachbearbeitungsschritt transkribiert und als Untertitel entsprechend direkt im Meeting oder in der Aufzeichnung angezeigt. Neben den offensichtlichen Vorteilen für Menschen mit Hörbehinderung kann dies auch in der Nachbereitung sehr praktisch sein. So ist es beispielsweise möglich, ein mehrstündiges Meeting innerhalb kürzester Zeit nachzuholen, indem das Transkript per Textsuche nach Schlagwörtern durchsucht wird (z.B. das eigene Thema oder der eigene Name). So findet man zügig die interessanten Stellen und muss nicht die gesamte Aufzeichnung durcharbeiten.

Wirklich interessant wird es dann bei der Verarbeitung der Sprache (Natural Language Processing). Denn hier ist auch immer ein gewisses Maß an Sprachverständnis notwendig, wodurch sich die Schwierigkeit deutlich erhöht. Es beginnt mit der automatischen Rechtschreibung und Grammatik-Korrektur und geht weiter mit der automatischen Übersetzung zwischen unterschiedlichen Sprachen.

Bei der automatischen Übersetzung von Nachrichtentexten wurde bereits die Vergleichbarkeit mit menschlichen Übersetzungen ausgerufen (buchstäblich im Titel des Papers: „Achieving Human Parity on Automatic Chinese to English News Translation“). Hier kam der oben erwähnte Ansatz des Trainings mit zwei intelligenten Systemen zum Einsatz, bei dem ein System Artikel vom Englischen ins Chinesische (und zurück) übersetzte, während ein zweites System die Ergebnisse überprüfte. Die Übersetzung zwischen Chinesisch (Mandarin) und Englisch ist dabei sowohl anspruchsvoller Benchmark zweier sehr unterschiedlicher Sprachen als auch ein wichtiger Eckstein für die Praxis, da es sich um die beiden meistgesprochenen Sprachen der Welt handelt.

Zusammen mit den bisher erwähnten Technologien sind somit alle Bausteine für die automatische Simultanübersetzung vorhanden. Wenn dann noch die Originalstimme des Sprechers nachgebildet werden kann, fallen plötzlich die Sprachbarrieren dieser Welt. Tatsächlich gibt es einige Firmen, die an der Simultanübersetzung arbeiten und oder sogar schon Systeme veröffentlichen, zum Beispiel Google und Baidu Translate. Allerdings sind diese für den Alltagsgebrauch noch nicht ausgereift. Und natürlich wird auch hier in der Regel der Fokus auf die Übersetzung zwischen Englisch und Chinesisch gesetzt.

Da sie in der Praxis jedoch extrem hilfreich sein können, findet man die Ansätze in Teilen gelegentlich bereits in der Anwendung. So erlebt man inzwischen auf Reisen in Asien durchaus die ein oder andere Hotel-Rezeption mit Unterstützung von Google Translate.

Bildverarbeitung

In der Bildverarbeitung kennen wir schon seit Jahrzehnten einfache Erkennungsalgorithmen für Buchstaben (OCR). Mittlerweile ist natürlich bedeutend mehr möglich. In Industrieanlagen und der Medizin sind automatische Objekterkennungsalgorithmen inzwischen stark vertreten, beispielsweise bei der Qualitätssicherung oder Krebsdiagnose.

Daneben sind sowohl die Erkennung von Personen als auch die Identifikation von Personen in Videobildern bereits technischer Standard und können z.B. im Webex-Board von Cisco beobachtet werden. So ist es möglich, das Videobild eines Meeting-Raums entsprechend der Besetzung auf eine passende Größe zu schneiden und die Teilnehmer mit virtuellen Namensschildern zu versehen. Letzteres Leistungsmerkmal wird in Europa jedoch für gewöhnlich aufgrund von Datenschutzbedenken nicht genutzt.

Für eigene Anwendungen kann die Personendetektion von Cisco Meraki genutzt werden, um beispielsweise auf Videoaufnahmen automatisch festzustellen, welche Räumlichkeiten wie intensiv genutzt werden und daraus Analysen (ohne Personenbezug) zu generieren.

Wer Google Lens noch nicht ausprobiert hat, dem empfehle ich, die App herunterzuladen und ein wenig damit zu spielen. Zwar funktioniert die Anwendung längst nicht mit allen Gegenständen, jedoch sind die Ergebnisse immer wieder erstaunlich. Dies gilt insbesondere ebenso für die Integration von Google Translate, wodurch Beschriftungen im Kamerabild in Echtzeit übersetzt und ersetzt werden. Damit findet man sich als Mitteleuropäer plötzlich ebenfalls in einem japanischen Supermarkt zurecht.

Neben der Verarbeitung von echten Daten gibt es auch bei den Bildern Möglichkeiten der Synthese. Besuchen Sie doch einmal die Webseite https://thispersondoesnotexist.com/, wenn Sie Menschen sehen möchten, die es in Wirklichkeit nicht gibt. Wie es sich für das Internet gehört, gibt es dasselbe noch einmal mit Katzenbildern und mehr. Auch hier kam wieder das zuvor erwähnte Zusammenspiel von verschiedenen KI-Systemen zum Tragen, wobei ein System die Bilder generiert und ein weiteres überprüft.

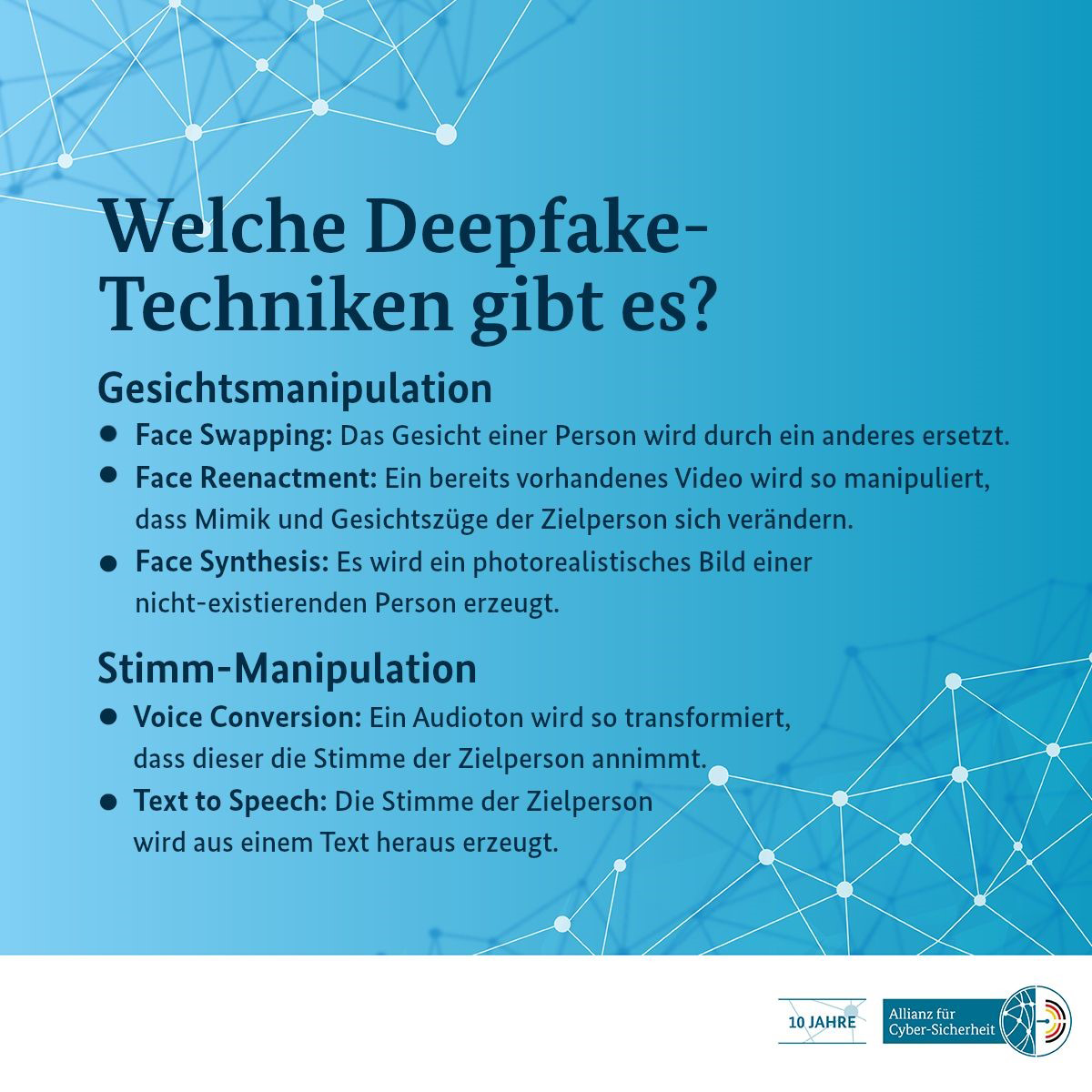

Häufig werden solche und ähnliche Techniken für die Synthese oder den Austausch von Audio- und Bilddaten auch als Deepfakes bezeichnet. Erst kürzlich hat das BSI wieder auf die Gefahren von Angriffen mit solchen Methoden hingewiesen (siehe Abbildung).

Abbildung 2: Deepfake-Techniken – Quelle: Allianz für Cyber-Sicherheit

Intelligente Systeme

Letztlich besteht doch immer wieder der Wunsch nach „intelligenten“ Gesamtsystemen, die Daten aus diversen Quellen aggregieren, verarbeiten und entsprechend handeln. Da sich mit den bislang diskutierten Technologien keine harte Künstliche Intelligenz konstruieren lässt, bleibt nur die geschickte Kombination bekannter Ansätze, um möglichst nahe an diese Vorstellungen heranzukommen. Wir sehen das in vielen „persönlichen Assistenten“ wie Siri, Cortana, Alexa oder dem Google Assistant, die man über Smart Speaker oder Smartphones (Hauptsache smart) meist per Stimme oder Tastendruck erreicht und die selbst sprechen, wecken oder das Küchenlicht anschalten können.

Nach den anfänglichen Sprüngen in deren Leistungsfähigkeit, insbesondere auf dem Feld der Sprachverarbeitung, hat sich der Markt dort ziemlich beruhigt. Natürlich geht es weiter voran, Geräte und Anwendungen werden fortlaufend besser, jedoch braucht es hierfür Zeit. Es ist nun einmal klassische Entwicklungsarbeit, die in die Systeme gesteckt werden muss, damit am Ende etwas möglichst Smartes dabei herauskommt.

Doch wurde ja auch schon viel geschafft. Wenn es uns gelingt, diese Technologien aus dem generischen Umfeld in die Unternehmenswelt mit hochspezifischen Daten(-banken) und Integrationen hineinzubekommen, dann lassen sich damit einige Mehrwerte erreichen. Das Feld Conversational AI ist ein großer Zukunftsmarkt und wird die kommenden Jahre im Omni-Channe-Bereich in der Form von Chat- und Voice-Bots noch sehr viel stärker prägen.

Denn nicht zuletzt kann trotz aller notwendigen Integrationsarbeit in solchen Projekten mit derartigen Verfahren nicht nur viel Geld gespart werden, sondern es kann auch sehr genau beziffert werden, wie viel. Was man jedoch lernen musste: Wenn man sehr offene Systeme mit menschlichem Input aus der Vergangenheit und Gegenwart füttert, gehören dazu ebenso die Abgründe dieser Daten inklusive Sexismus, Rassismus etc. Das sind echte Probleme, die sich nicht so leicht lösen lassen, wie man im ersten Moment zu glauben vermag. Denn es gibt in solchen Anwendungen nun einmal keinen Regler, mit dem sich die massenhaft gelernten Inhalte hinsichtlich eines gewünschten Aspekts verändern ließen. Das ist ein grundlegendes Problem von lernenden Systemen und kommt in Enterprise-Anwendungen natürlich überhaupt nicht gut an.

Letztlich muss also noch viel gefeilt werden, und dann braucht es seine Zeit, bis nach und nach mehr Anwendungsfelder abgedeckt werden können. Bedenken Sie nur, wie nützlich Suchmaschinen inzwischen geworden sind. Hier spielt zum Beispiel auch Microsoft ganz bedeutend mit. Trotzdem ist die milliardenfach vorhandene Windows-Suche noch immer solch ein Graus, dass viele Anwender sie bereits aus ihrem täglichen Gebrauch wegrationalisiert haben.

Bis der Stand der Technik den Alltag der breiten Öffentlichkeit erreicht, wird noch einige Zeit vergehen. Deshalb ist es um die Künstliche Intelligenz ein klein wenig ruhiger geworden. Das liegt zum einen daran, dass weniger spektakuläre neue Ansätze und Use Cases auftauchen, und zum anderen existieren ja bereits eine ganze Reihe von Anwendungen, die nun zur Marktreife gebracht werden müssen. Dafür gibt es noch viel zu tun, denn dahinter steckt viel klassische Ingenieursleistung, und die kostet Personal, Aufwand und letztlich natürlich auch Zeit.

Allerdings sollten wir nicht vergessen, dass wir hier nicht über eine einzelne Technologie sprechen, sondern bestenfalls über eine Familie von Ansätzen, die in sehr unterschiedliche Umsetzungen münden. Und für einige dieser Technologien kann man behaupten, dass wir schon in die späteren Phasen des Hype-Zyklus eintreten. Dazu gehört ebenfalls das sogenannte Plateau der Produktivität. Das klingt etwas ernüchternd, und tatsächlich ist es so, dass sich erst über die Höhe dieses Plateaus entscheiden wird, welche Rolle diese Technologien letztlich in unserem Leben spielen werden. Eines ist jedoch sicher: Vollständig wieder verschwinden werden sie jedenfalls nicht.